Die Zahl der Vorab-Veröffentlichungen von Forschungsergebnissen auf Preprint-Servern hat zuletzt rasant zugenommen – unter anderem auch stark befeuert durch die COVID-19-Pandemie. Zugleich betreiben die meisten akademischen Institutionen seit vielen Jahrzehnten die guten, alten „Journal Clubs“, in denen bereits begutachtete und publizierte Studienresultate kritisch besprochen werden. Warum angesichts dessen nicht zwei Fliegen mit einer Klappe schlagen, dachten sich offenbar vor drei Jahren eine Handvoll Jungforschende: Warum nicht gewisse Synergien erzeugen, indem man den „Journal Club“ in einen „Preprint Club“ umwandelt?

Ungefähr so entstand 2020 die Idee zu einem institutionsübergreifenden Preprint Club (preprintclub.com), um via Online-Treffen neue immunologische Studien zu bewerten, die auf den Preprint-Servern bioRxiv und medRxiv erschienen waren. Keimzelle waren junge Immunologinnen und Immunologen an der Icahn School of Medicine at Mount Sinai in New York City und der University of Oxford, später kamen weitere vom Stockholmer Karolinska-Institut und der University of Toronto hinzu.

Fünf von ihnen haben den Gründungsprozess und die Idee dahinter gerade in Nature (doi: 10.1038/d41586-023-01819-y) genauer beschrieben. Darin halten sie fest: Diesen Beitrag weiterlesen »

Dank Herrn Musk heißt Twitter heute bekanntlich X. Dennoch wird auch für X gelten, was ein US-Team gerade unter dem Titel „Controlled experiment finds no detectable citation bump from Twitter promotion“ veröffentlicht hat (bioRXiv,

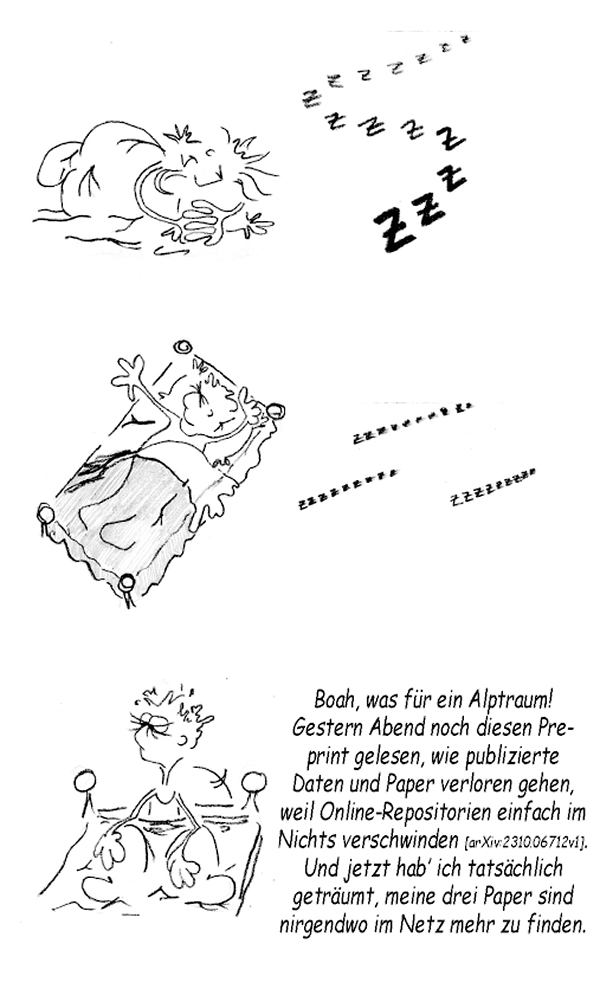

Dank Herrn Musk heißt Twitter heute bekanntlich X. Dennoch wird auch für X gelten, was ein US-Team gerade unter dem Titel „Controlled experiment finds no detectable citation bump from Twitter promotion“ veröffentlicht hat (bioRXiv,  Öfter schon haben wir über „Zombie-Paper“ gemeckert. Artikel also, die trotz erfolgter Retraction munter weiter zitiert werden. Beispielsweise

Öfter schon haben wir über „Zombie-Paper“ gemeckert. Artikel also, die trotz erfolgter Retraction munter weiter zitiert werden. Beispielsweise

Seien wir mal ehrlich: Funktionierten nicht viele wichtige Arbeiten in der Geschichte der Biologie im Wesentlichen nach dem folgendem Muster:

Seien wir mal ehrlich: Funktionierten nicht viele wichtige Arbeiten in der Geschichte der Biologie im Wesentlichen nach dem folgendem Muster: Wie listet man in der Referenzliste ein zitiertes Paper, das einen Druckfehler im Titel hat? Interessante Frage, die Timothy McAdoo von APA Style

Wie listet man in der Referenzliste ein zitiertes Paper, das einen Druckfehler im Titel hat? Interessante Frage, die Timothy McAdoo von APA Style