Mit der Zeit hat unser Forscher Ernst gelernt, bei seinen Experimenten möglichst alle Variablen mitzuberücksichtigen …

(Gezeichnet von Rafael Florés. Über 200 weitere Labor-Abenteuer von „Forscher Ernst“ gibt es hier.)

Mit der Zeit hat unser Forscher Ernst gelernt, bei seinen Experimenten möglichst alle Variablen mitzuberücksichtigen …

(Gezeichnet von Rafael Florés. Über 200 weitere Labor-Abenteuer von „Forscher Ernst“ gibt es hier.)

Nicht nur einschlägige Umfragen kommen zu dem Schluss, dass ein guter Teil derjeniger, die Manuskripte für Veröffentlichungen begutachten, das Peer-Review-System für unlautere Zwecke missbraucht. Auch uns wurden immer wieder entsprechende Fälle berichtet. Zuletzt schrieb uns etwa eine Genetikerin [der Name ist der Redaktion bekannt] die folgenden Zeilen:

Nicht nur einschlägige Umfragen kommen zu dem Schluss, dass ein guter Teil derjeniger, die Manuskripte für Veröffentlichungen begutachten, das Peer-Review-System für unlautere Zwecke missbraucht. Auch uns wurden immer wieder entsprechende Fälle berichtet. Zuletzt schrieb uns etwa eine Genetikerin [der Name ist der Redaktion bekannt] die folgenden Zeilen:

In den vergangenen sechs Jahren musste ich bei drei Manuskripten erleben, dass die Gutachter ihre Position eindeutig missbrauchten, um deren Veröffentlichung zu verhindern. Im ersten Fall rief ich den Editor an und sagte ihm, dass ich wüsste, wer der Gutachter sei – und dass er mit sehr schwachen Argumenten versuche, unsere Veröffentlichung zu verhindern. Der Editor gab am Ende zwar zu, dass es sich tatsächlich um diese Person handelte. Trotzdem lehnte er das Manuskript ab.

In den nächsten Fall war interessanterweise wieder derselben Editor verwickelt, den ich mir leider nicht aussuchen konnte. Diesmal verhinderte ein anderer Gutachter unsere Veröffentlichung, indem er zunächst zwei langwierige Überarbeitungen verlangte – um schließlich doch alles abzulehnen. Vier Wochen später veröffentliche er in einer anderen Zeitschrift einen Artikel zum selben Thema. Seine Resultate hatten zwar nicht direkt etwas mit unseren Ergebnissen zu tun, aber offenbar wollte er dennoch einfach schneller sein.

Der letzte Fall ereignete sich vor zwei Jahren, als ein Gutachter, der zu den führenden Wissenschaftlern auf unserem Gebiet gehört, unser Manuskript mit ungewöhnlich seltsamen Argumenten ablehnte. Glücklicherweise bemerkte der Editor dies jedoch – und nahm die Arbeit an, da die beiden anderen Gutachter positiv urteilten.

Ich glaube, dass einige Wissenschaftler das Peer-Review-System auf diese Weise missbrauchen, da sie als Gutachter anonym bleiben und sie daher glauben, dass die Autoren ihre Identität nicht herausfinden werden. Dennoch habe ich keine Lösung für dieses Problem. Zwar veröffentlichen einige Zeitschriften inzwischen die Namen der Gutachter, allerdings befürchte ich, dass vor diesem Hintergrund vermehrt Manuskripte angenommen werden, die nicht den eigentlichen Standards der Zeitschriften entsprechen – einfach weil die Gutachter kritische Argumente, auch wenn sie berechtigt sind, zurückhalten könnten, um nicht ihre eigenen Beziehungen zu den Autoren zu gefährden.

Das lassen wir jetzt mal so stehen, nehmen aber gerne andere Erfahrungen, Meinungen und Vorschläge zum Thema entgegen …

(Illustr.: Adobe Firefly)

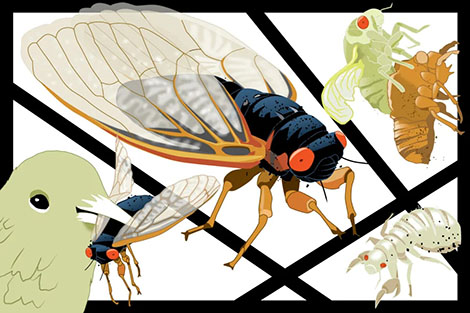

Die Fressorgie des Jahrhunderts naht – zumindest wenn man Zikaden mag. In diesem Frühjahr werden sich im Osten der USA innerhalb weniger Wochen schätzungsweise eine Billion Larven aus der Gattung der Magicicada, der Periodischen Zikaden, nach oben graben und aus ihren Erdlöchern schlüpfen. Mit bis zu 400 Individuen pro Quadratmeter. Bilder einer biblischen Wanderheuschreckenplage drängen sich förmlich auf.

Die Fressorgie des Jahrhunderts naht – zumindest wenn man Zikaden mag. In diesem Frühjahr werden sich im Osten der USA innerhalb weniger Wochen schätzungsweise eine Billion Larven aus der Gattung der Magicicada, der Periodischen Zikaden, nach oben graben und aus ihren Erdlöchern schlüpfen. Mit bis zu 400 Individuen pro Quadratmeter. Bilder einer biblischen Wanderheuschreckenplage drängen sich förmlich auf.

Zum Glück sind die Pflanzensaftsauger für Mensch und Tier harmlos. Weder stechen oder beißen sie noch übertragen sie Krankheiten. Das Außergewöhnliche an ihnen: Magicicada treten stets im Rudel auf – und diesmal in einem außerordentlich großen. Reihte man alle bis Ende April erwarteten Zikaden aneinander, so reichte die Insekten-Polonaise mehr als dreißigmal bis zum Mond und wieder zurück.

Ohne jahrelange minutiöse Vorbereitung wäre ein solches Massenauftreten natürlich unmöglich. Über ein Jahrzehnt durchlaufen Magacicada-Larven unterirdisch fünf Larvenstadien. Das letzte von ihnen arbeitet sich dann im Frühjahr des 13. oder 17. Jahres in Richtung Erdoberfläche … und wartet. Worauf? Auf die richtige Temperatur. Erreicht der Boden etwa 18 Grad Celsius, krabbeln sie ins Freie und häuten sich ein letztes Mal zur komplett schwarzen Imago mit ihren charakteristisch roten Komplexaugen. Das Besondere in diesem Jahr: Die 13- und 17-Jahresbruten überlappen. Zuletzt war das 1803 der Fall, das nächste Mal wird es voraussichtlich 2245 sein. Die Fressorgie kann also beginnen.

Allerdings weniger für die Zikaden selbst. Mehr für Spinnen, Raubwanzen, Ameisen und Vögel, die schon mal ihre Mandibeln, Cheliceren oder Schnäbel wetzen können. Für sie wird das Schlaraffenland wahr.

Übrigens auch für den Menschen – falls er denn will. Denn auf der Weltliste essbarer Insekten stehen auch alle Periodischen Zikaden. Gewiefte Insektenköche an der US-Ostküste werden sie ohne Zweifel auf Pizza, in Paella oder als Sushi verarbeiten. Mit einem physiologischen Brennwert von etwa 150 Kilokalorien pro Imago sind sie schließlich ebenso nahrhaft wie gebratenes Hühnchen – dafür aber garantiert aus Freilandhaltung und bei Selbstzubereitung zum Nulltarif.

Aber warum wird diese Delikatesse nur alle 13 beziehungsweise 17 Jahre serviert? Aus Überlebenskalkül. Indem die Magicicada nur alle 13 oder 17 Jahre in Scharen auftreten, werden ihre Fressfeinde übersättigt. Diese leben in der Regel in 1-, 2-, 4- oder 6-Jahresrhythmen und können ihre Reproduktionszyklen daher nur schwer mit den Primzahlen der Periodischen Zikaden synchronisieren. Es bleiben immer ausreichend Zikaden übrig, die nicht gefressen werden. Ihr Arterhalt ist gesichert.

So dramatisch wie ihre Zeit über der Erde ist, so kurz ist sie auch. Lediglich sechs Wochen bleiben Magicicada, um sich zu paaren – und zu sterben: die Männchen direkt nach dem Akt; die Weibchen, nachdem sie noch schnell Hunderte von Eiern in die Rinde lebender Zweige gelegt haben. Zwei Monate später schlüpft aus ihnen dann das erste Larvenstadium, fällt zu Boden und gräbt sich ein, um seine 13- oder 17-jährige Larvalentwicklung zu beginnen.

Die zwei Primzahlen haben die Tierchen also tief verinnerlicht. Welches Insekt „kann“ noch mehr Mathematik? Wir nehmen gerne Beispiele.

Henrik Müller

(Der Text erschien in leicht anderer Form als Editorial unseres aktuellen Laborjournal-NEWSLETTERS. Wer den NEWSLETTER samt solcher Editorials regelmäßig alle zwei Wochen per E-Mail zugeschickt bekommen möchte, klicke sich bitte hier entlang!)

Die Osterinsel birgt immer noch Geheimnisse und Überraschungen. Gerade erst entdeckte etwa eine Gruppe von Wissenschaftlern unter der Leitung des Zoologen Ernest Bunnyway von der Universität Uovo in nahezu unzugänglichen Ecken im Norden der Insel eine neue Vogelart. Versteckt zwischen saftigen Grashalmen fanden Bunnyway und Co. ein Nest mit Eiern, die in allen Farben des Regenbogens gefärbt waren: blaue Eier, rote Eier, grüne Eier, Eier mit Streifen, Zickzacklinien oder Punkten – unendlich viele Varianten.

„Wir waren wochenlang in derselben Gegend im Norden unterwegs, irgendwann hatten wir uns sogar verlaufen“, erzählt Bunnyway Laborjournal. „Doch plötzlich sahen wir diesen Vogel, der aus seinem Nest flüchtete. Er war so schnell, dass wir kein Foto machen konnten. Also näherten wir uns dem Nest – und wir trauten unseren Augen nicht: Keiner von uns hatte je ein so buntes Gelege gesehen.

Im Gegensatz zu seinen Eiern hatte der Vogel selbst eine bemerkenswert unauffällige Zeichnung. Sein braunes, weiches Gefieder sah fast wie ein Fell aus; das Tier war mittelgroß, hatte fleischige Füße und einen kurzen Schnabel. „Nicht unähnlich einem Huhn“, kommentierte Bunnyway. Doch trotz der großen Ähnlichkeit mit Hühnern sind die Wissenschaftler überzeugt, dass die neue Art, die sie in Anlehnung an den bis ins 19. Jahrhundert auf der Insel praktizierten Vogelmannkult Tangata manu tauften, ein Vertreter einer neuen Vogelfamilie ist – und tauften sie Easteridae.

Zurück in ihrem Basislager in Hanga Roa begannen die Wissenschaftler mit der Beschreibung der Art. Der Expeditionsteilnehmer und Ethnologe Birdy Egglestone sprach mit einigen Eingeborenen und erfuhr von ihnen, dass sie die bunten Eier für bestimmte rituelle Zeremonien verwenden, die meist im Frühjahr stattfinden. „Ein Eingeborener berichtete, dass sie jedes Frühjahr ihre Kinder aussenden, um ein paar der schönsten Exemplare zu suchen und zu sammeln. Wenn sie zurückkommen, werden die Eier gekocht und im Rahmen eines großen Familienfestes gegessen.“ Dieser Kult würde schon seit Hunderten von Jahren praktiziert.

Der potenzielle evolutionäre Nutzen hinter dem auffälligen Aussehen der Eier ist indes noch nicht geklärt. Bunnyway vermutet eine gerissene Täuschungs- oder Verwirrungstaktik. Diesbezüglich sind jedoch weitere Untersuchungen notwendig, um zu einem zufrieden stellenden Ergebnis zu kommen. „Wir werden bald wieder in den Norden fahren“, verkündet Bunnyway. „Und vielleicht werden wir dieses Mal schnell genug sein, um ein Exemplar zu fangen.“ Der Plan ist, DNA zu sammeln und die phylogenetischen Beziehungen von Tangata manu ein für alle Mal zu klären. Für diese Analyse veranschlagen die Wissenschaftler etwa ein Jahr. Dann seien die bewilligten Fördermittel für das Projekt sowieso verbraucht, so Bunnyway.

In der Zwischenzeit wünscht Laborjournal seinen Leserinnen und Lesern eine schöne Osterzeit.

(Foto: ivabalk@Pixabay)

Neben Politik und Wirtschaft ist sicherlich die Wissenschaft das dritte große Seilschaften-Dorado.

…, so stand es unlängst in einem Essay zu lesen.

Da ist sicher was dran. Denn wo man hinsichtlich Begutachtungen, Berufungen, Fördermitteln, Evaluationen, Zitierungen et cetera derart von „Peers“ abhängig ist, da wird man wohl förmlich gedrängt zu Cliquenbildung, Gschaftlhuberei, Günstlingswirtschaft, … Und eine Ausprägung davon sind bisweilen Zitierkartelle.

Nehmen wir zunächst den aufrichtigen Wissenschaftler. Wenn er seine Resultate veröffentlicht, sieht er es als seine ehrenhafte Pflicht an, sämtliche relevanten Vorarbeiten zu zitieren. Auch solche von Personen, mit deren Inhalten er ansonsten nicht übereinstimmt – schließlich werden womöglich gerade dadurch fruchtbare Diskussionen befördert. Ordnungsgemäßes und gründliches Zitieren ist für ihn somit ein klares Qualitätsmerkmal seiner Forschungstätigkeit.

Doch so denken bei weitem nicht alle. Für andere sind Zitate vielmehr ein schnödes Mittel, das gewinnbringend für die eigene Karriere genutzt werden kann. Von daher zitieren sie ausschließlich die Arbeiten ihrer Freunde und Kollegen, die im Gegenzug wiederum sie selbst zitieren. Auf diese Weise entstehen Gruppen gleichgesinnter Kollegen, in denen jeder jeweils die Karrieren der anderen fördert – Zitierkartelle eben. Diesen Beitrag weiterlesen »

„Open is not forever: A study of vanished open access journals“ titelte vor gut zwei Jahren ein finnisch-deutsches Trio seine Studie über das Verschwinden digital publizierter Forschungsartikel aus dem Internet (J. Assoc. Inf. Sci. Technol. 72, 1115-16). Der Übergang zum digitalen Publizieren und insbesondere die Einführung des offenen Zugangs (Open Access) habe zu Unsicherheit und Komplexität geführt, schreiben sie im Abstract. Insbesondere sei die langfristige Zugänglichkeit von Zeitschriften nicht immer gewährleistet, sodass sie bisweilen sogar ganz aus dem Netz verschwinden können.

Als Ergebnis ihrer Analyse hielten die Drei schließlich fest:

Wir haben 174 Open-Access-Zeitschriften gefunden, die mangels umfassender und offener Archive zwischen 2000 und 2019 aus dem Netz verschwunden sind. Alle wichtigen Forschungsdisziplinen und geografischen Regionen der Welt waren abgedeckt. Unsere Ergebnisse geben daher Anlass zu großer Sorge um die Integrität der wissenschaftlichen Aufzeichnungen. Sie unterstreichen die Dringlichkeit, gemeinsame Maßnahmen zu ergreifen, um einen kontinuierlichen Zugang zu gewährleisten und den Verlust von mehr wissenschaftlichem Wissen zu verhindern.

Offenbar sahen die Autoren damals jedoch nur die berühmte Spitze des Eisbergs. Denn was der Londoner Martin Paul Eve jetzt unter dem Titel “Digital Scholarly Journals Are Poorly Preserved: A Study of 7 Million Articles” zum Thema nachlegt, dürfte die geäußerten Sorgen nochmals vergrößern (Journal of Librarianship and Scholarly Communication 12(1). doi: https://doi.org/10.31274/jlsc.16288). Eve hatte überprüft, ob 7.438.037 mit digitalen Objektkennungen (DOI) versehene Forschungsartikel in den einschlägigen Online-Archiven vorhanden sind (institutionelle Repositorien waren nicht berücksichtigt). Sage und schreibe 2.056.492 Artikel waren trotz aktiver DOI darin nicht mehr auffindbar – also rund 28 Prozent. Diesen Beitrag weiterlesen »

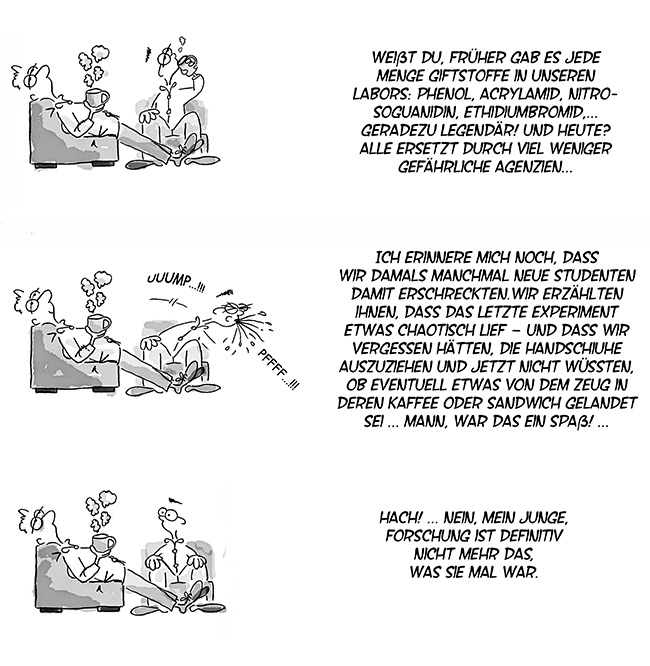

Je älter unser Forscher Ernst wird, desto mehr trauert er auf ganz eigene Weise den guten, alten Zeiten nach. „Früher war alles besser im Labor“ kann man daraus allerdings nicht unbedingt schließen …

(Gezeichnet von Rafael Florés. Über 200 weitere Labor-Abenteuer von „Forscher Ernst“ gibt es hier.)

Ihr Opfer war so gut wie tot, das stand außer Frage. Noch krabbelte es auf zittrigen Beinen am Rand des leuchtend roten Fangeisens entlang, noch tastete es mit seinen Fühlern nach dem süßlichen, fauligen, verführerischen Duft ihrer Nektardrüsen. Doch nur wenige Millimeter weiter, und es würde mehrere ihrer Sinneshärchen berühren und die gespannten Tellereisen ihrer Fangblätter binnen 100 Millisekunden zuschnappen lassen. Widerstand war zwecklos.

Natürlich könnte sich Dionaea muscipula, die Venusfliegenfalle, von Sonnenlicht, Kohlendioxid, Wasser und Mineralien des Bodens ernähren. Doch jeden Morgen wacht sie auf und entscheidet sich aufs Neue für etwas anderes: Gewalt!

Natürlich könnte sich Dionaea muscipula, die Venusfliegenfalle, von Sonnenlicht, Kohlendioxid, Wasser und Mineralien des Bodens ernähren. Doch jeden Morgen wacht sie auf und entscheidet sich aufs Neue für etwas anderes: Gewalt!

Warum? Weil sie an ihrem nährstoffarmen Standort einfach nicht auf die Stickstoff-Leckerli verzichten kann, die auf ihr herumkrabbeln.

Hat sie einen Arthropoden in einem ihrer Fangblätter eingeschlossen, bewerten Chemorezeptoren dessen Verwertbarkeit. Erachtet sie ihr Opfer als schmackhaft, versiegelt sie das klebrige Grab vollständig. Selbst Flüssigkeit kann dann nicht mehr austreten. Kleine Drüsen sondern nun ein Verdauungssekret ab, dessen Amylasen, Esterasen, Phosphatasen, Proteasen, Ribonukleasen und in geringen Mengen auch Chitinasen den gefangenen Gliederfüßer bis auf Molekülebene zersetzen. Nach zehn Tagen ist das Festmahl vorbei. Nur unverdauliche Reste wie Beine und Chitinpanzer bleiben übrig und fallen zu Boden, sobald sich die Fangblätter erneut öffnen und aufrichten. Das Massengrab zu Füßen der Venusfliegenfalle wächst. Diesen Beitrag weiterlesen »

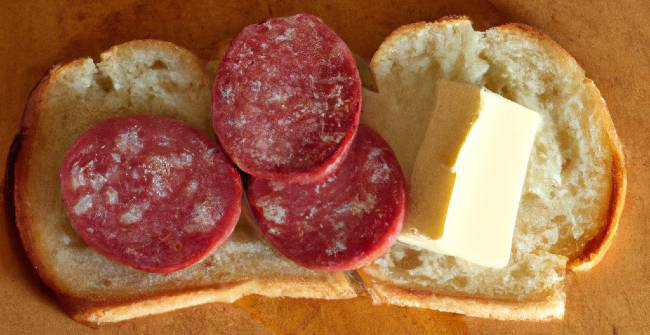

Veröffentlichungen sind das Brot des Wissenschaftlers. Doch trocken schmeckt es ihm nicht. Erst wenn ordentlich Butter und Belag in Form von Zitierungen draufgeschmiert werden, wird es ihm zum wirklichen Genuss. Und zwar je dicker, umso mehr – seit der Einfluss von Impact-Punkten und Zitierzahlen bei der Bewertung von Forschungsqualität fast schon ins Absurde gewachsen ist.

Seit Langem haben wir in mehreren Beiträgen versucht klarzumachen, dass die reine Zahl der Zitate den echten Einfluss der zitierten Arbeit auf nachfolgende Forschung nur sehr unzureichend widerspiegelt – und damit letztlich auch nicht ihre tatsächliche Qualität (siehe etwa „Wachsweiche Zitierzahlen“, „Zitierungen — Kein Maß für Qualität oder Einfluss“ oder „Mehr Zitate durch Open Data“).

Stimmt aber womöglich wenigstens der Umkehrschluss, dass Publikationen, die nicht zitiert werden, gar keinen Wert für nachfolgende Forschung haben? Dazu ein Zitat von Dag W. Aksnes, Professor am Nordic Institute for Studies in Innovation, Research and Education in Oslo:

So einfach ist es nicht, dass Artikel ohne Zitate wenig Wert haben. Sie können dennoch wichtig sein, um die Forschung voranzubringen. Sie können zum Beispiel die Ergebnisse früherer Studien bestätigen oder zeigen, dass zwei Dinge nicht miteinander verbunden sind.

Rein konfirmatorische Studien und negative Ergebnisse also. Genau das, was die Zeitschriften gerne ablehnen, da es den Zitatefluss für ihren Journal-Impact-Faktor zum Stottern bringt. Und was die Autorinnen und Autoren daher nicht nur den Belag, sondern oft genug gleich das ganze Brot kostet.

Dabei ist der wahre Wert konfirmatorischer Studien und negativer Ergebnisse für den wissenschaftlichen Fortschritt längst gezeigt (siehe etwa „Vom Triangulieren beim Experimentieren“, „Warum so negativ?“ oder „Negativ hilft“). So wäre beispielsweise die aktuelle Repliktionskrise sicherlich deutlich kleiner, würden mehr davon durchgeführt, publiziert – und auch trotz vergleichsweise magerer Zitierraten entsprechend honoriert.

Manche Scheibe Brot kann schlichtweg auch ohne fetten Belag ziemlich schmackhaft sein.

Ralf Neumann

(Illustration kreiert via Dall-E2)

Aus unserer Reihe „Gut gesagt!“ zum Thema „Wissenschaftszeitvertragsgesetz (WisszeitVG) und befristete Stellen in der Forschung“:

__________________________

__________________________

[…] Die Hochschulen bieten unter solchen Bedingungen weniger die Rahmenbedingungen für Forschung als maximal noch für die Ausarbeitung von Forschungsphantasien, die mangels finanzieller Ressourcen zum überwiegenden Teil nie in die Tat umgesetzt werden. Damit geht der gesellschaftliche Mehrwert von Wissenschaft verloren: Bewerbungen und die Konkurrenz um Drittmittel werden zum Selbstzweck, dem sich alles andere unterzuordnen hat. Wissenschaftlerinnen und Wissenschaftler werden durch die künstliche Erschaffung existenzieller Nöte dazu gezwungen, nur auf den eigenen Nutzen zu schauen, statt für das Gemeinwohl zu arbeiten – ein Ziel, das viele von ihnen ursprünglich gerade zur Wahl ihres Berufes motiviert haben dürfte. Die Folge ist Frustration auf allen Ebenen. […]

__________________________

… Schrieben Amrei Bahr, Kristin Eichhorn und Sebastian Kubon in Laborjournal 7-8/2022 („#IchBinHanna – Warum prekäre Arbeit der Wissenschaft nachhaltig schadet“, S. 34-37).