Nicht nur einschlägige Umfragen kommen zu dem Schluss, dass ein guter Teil derjeniger, die Manuskripte für Veröffentlichungen begutachten, das Peer-Review-System für unlautere Zwecke missbraucht. Auch uns wurden immer wieder entsprechende Fälle berichtet. Zuletzt schrieb uns etwa eine Genetikerin [der Name ist der Redaktion bekannt] die folgenden Zeilen:

Nicht nur einschlägige Umfragen kommen zu dem Schluss, dass ein guter Teil derjeniger, die Manuskripte für Veröffentlichungen begutachten, das Peer-Review-System für unlautere Zwecke missbraucht. Auch uns wurden immer wieder entsprechende Fälle berichtet. Zuletzt schrieb uns etwa eine Genetikerin [der Name ist der Redaktion bekannt] die folgenden Zeilen:

In den vergangenen sechs Jahren musste ich bei drei Manuskripten erleben, dass die Gutachter ihre Position eindeutig missbrauchten, um deren Veröffentlichung zu verhindern. Im ersten Fall rief ich den Editor an und sagte ihm, dass ich wüsste, wer der Gutachter sei – und dass er mit sehr schwachen Argumenten versuche, unsere Veröffentlichung zu verhindern. Der Editor gab am Ende zwar zu, dass es sich tatsächlich um diese Person handelte. Trotzdem lehnte er das Manuskript ab.

In den nächsten Fall war interessanterweise wieder derselben Editor verwickelt, den ich mir leider nicht aussuchen konnte. Diesmal verhinderte ein anderer Gutachter unsere Veröffentlichung, indem er zunächst zwei langwierige Überarbeitungen verlangte – um schließlich doch alles abzulehnen. Vier Wochen später veröffentliche er in einer anderen Zeitschrift einen Artikel zum selben Thema. Seine Resultate hatten zwar nicht direkt etwas mit unseren Ergebnissen zu tun, aber offenbar wollte er dennoch einfach schneller sein.

Der letzte Fall ereignete sich vor zwei Jahren, als ein Gutachter, der zu den führenden Wissenschaftlern auf unserem Gebiet gehört, unser Manuskript mit ungewöhnlich seltsamen Argumenten ablehnte. Glücklicherweise bemerkte der Editor dies jedoch – und nahm die Arbeit an, da die beiden anderen Gutachter positiv urteilten.

Ich glaube, dass einige Wissenschaftler das Peer-Review-System auf diese Weise missbrauchen, da sie als Gutachter anonym bleiben und sie daher glauben, dass die Autoren ihre Identität nicht herausfinden werden. Dennoch habe ich keine Lösung für dieses Problem. Zwar veröffentlichen einige Zeitschriften inzwischen die Namen der Gutachter, allerdings befürchte ich, dass vor diesem Hintergrund vermehrt Manuskripte angenommen werden, die nicht den eigentlichen Standards der Zeitschriften entsprechen – einfach weil die Gutachter kritische Argumente, auch wenn sie berechtigt sind, zurückhalten könnten, um nicht ihre eigenen Beziehungen zu den Autoren zu gefährden.

Das lassen wir jetzt mal so stehen, nehmen aber gerne andere Erfahrungen, Meinungen und Vorschläge zum Thema entgegen …

(Illustr.: Adobe Firefly)

Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel

Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel

Kaum etwas bietet Wissenschaftlerinnen und Wissenschaftlern derart viel Anlass zu Diskussionen wie der Peer-Review. Das Peer-Review-System sei

Kaum etwas bietet Wissenschaftlerinnen und Wissenschaftlern derart viel Anlass zu Diskussionen wie der Peer-Review. Das Peer-Review-System sei

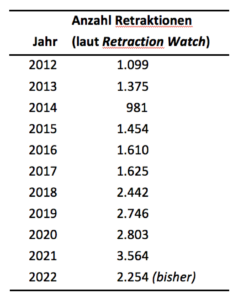

Eine Retraktion Ihres neuesten Artikels wäre das Beste, das Ihnen passieren kann – zumindest hinsichtlich Ihres Bekanntheitsgrades. Diese Aussage macht keinen Sinn, finden Sie? Schließlich kann eine widerrufene Publikation nicht mehr zitiert werden – schon allein weil sie Fehler enthält? Weit gefehlt.

Eine Retraktion Ihres neuesten Artikels wäre das Beste, das Ihnen passieren kann – zumindest hinsichtlich Ihres Bekanntheitsgrades. Diese Aussage macht keinen Sinn, finden Sie? Schließlich kann eine widerrufene Publikation nicht mehr zitiert werden – schon allein weil sie Fehler enthält? Weit gefehlt. Zudem gibt es manchmal auch keine andere als die zurückgezogene Publikation, die zum Beispiel eine bestimmte Methode beschreibt. Überhaupt muss ja nicht alles an einem zurückgezogenen Artikel falsch sein.

Zudem gibt es manchmal auch keine andere als die zurückgezogene Publikation, die zum Beispiel eine bestimmte Methode beschreibt. Überhaupt muss ja nicht alles an einem zurückgezogenen Artikel falsch sein.