Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel „What’s Wrong With Peer Review?“ Darin stellt die Autorin die Frage, ob angesichts vieler aufsehenerregender Retractions in der jüngsten Vergangenheit der Peer-Review-Prozess seine Funktion überhaupt noch erfüllt – nämlich zu entscheiden, welche Studien tatsächlich zur Veröffentlichung taugen.

Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel „What’s Wrong With Peer Review?“ Darin stellt die Autorin die Frage, ob angesichts vieler aufsehenerregender Retractions in der jüngsten Vergangenheit der Peer-Review-Prozess seine Funktion überhaupt noch erfüllt – nämlich zu entscheiden, welche Studien tatsächlich zur Veröffentlichung taugen.

In dem Artikel erregte ein Zitat der Chief-Editorin von Nature, Magdalena Skipper, besondere Aufmerksamkeit. Hinsichtlich des Aufdeckens gezielter Fälschungen in Forschungsartikeln hält sie fest, dass dies keineswegs Job der Reviewer ist – und fügt hinzu:

Ich möchte meine Peer-Reviewer eigentlich nicht als eine Art Polizeikommando ansehen, das solches Fehlverhalten aufspürt.

Schon im Artikel werden Editoren-Kollegen mit anderer Meinung zitiert. Für noch mehr Diskussionen sorgte Skippers Aussage indes in den Sozialen Medien. So wunderte sich etwa die australische Psychologie-Professorin Simine Vazire auf X (ehemals Twitter):

Die Zitate der Nature-Chief-Editorin Magdalena Skipper zur Frage, ob Zeitschriften im Rahmen des Peer-Review auch auf Fehler und Datenqualität prüfen sollten, überraschen mich doch sehr.

Und mit dieser Überraschung war sie bei weitem nicht allein. Diesen Beitrag weiterlesen »

Öfter schon haben wir über „Zombie-Paper“ gemeckert. Artikel also, die trotz erfolgter Retraction munter weiter zitiert werden. Beispielsweise

Öfter schon haben wir über „Zombie-Paper“ gemeckert. Artikel also, die trotz erfolgter Retraction munter weiter zitiert werden. Beispielsweise

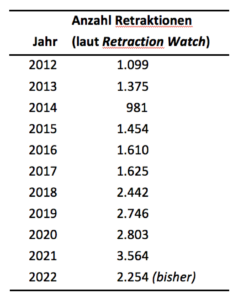

Eine Retraktion Ihres neuesten Artikels wäre das Beste, das Ihnen passieren kann – zumindest hinsichtlich Ihres Bekanntheitsgrades. Diese Aussage macht keinen Sinn, finden Sie? Schließlich kann eine widerrufene Publikation nicht mehr zitiert werden – schon allein weil sie Fehler enthält? Weit gefehlt.

Eine Retraktion Ihres neuesten Artikels wäre das Beste, das Ihnen passieren kann – zumindest hinsichtlich Ihres Bekanntheitsgrades. Diese Aussage macht keinen Sinn, finden Sie? Schließlich kann eine widerrufene Publikation nicht mehr zitiert werden – schon allein weil sie Fehler enthält? Weit gefehlt. Zudem gibt es manchmal auch keine andere als die zurückgezogene Publikation, die zum Beispiel eine bestimmte Methode beschreibt. Überhaupt muss ja nicht alles an einem zurückgezogenen Artikel falsch sein.

Zudem gibt es manchmal auch keine andere als die zurückgezogene Publikation, die zum Beispiel eine bestimmte Methode beschreibt. Überhaupt muss ja nicht alles an einem zurückgezogenen Artikel falsch sein.

Worin unterscheidet sich die Wissenschaft von Pfannen? Zugegeben, der Kalauer mag an den Haaren herbeigezogen sein — aber sei‘s drum: Pfannen reinigen sich immer besser selbst, in der Wissenschaft dagegen…

Worin unterscheidet sich die Wissenschaft von Pfannen? Zugegeben, der Kalauer mag an den Haaren herbeigezogen sein — aber sei‘s drum: Pfannen reinigen sich immer besser selbst, in der Wissenschaft dagegen… Schon seit einiger Zeit muss der Zürcher Pflanzenforscher

Schon seit einiger Zeit muss der Zürcher Pflanzenforscher