Kürzlich erhielt die Laborjournal-Redaktion eine E-Mail, in der der Verfasser die Begutachtungspolitik der Else Kröner-Fresenius-Stiftung folgendermaßen kritisiert:

Ich habe mit dem Begutachtungsverfahren der Else Kröner-Fresenius-Stiftung äußerst negative Erfahrungen gemacht.

Zwei meiner im Abstand von etwa 12 Monaten eingereichten Anträge zu unterschiedlichen wissenschaftlichen Fragestellungen wurden bereits nach jeweils 2-monatiger Bearbeitungszeit abgelehnt. In der schriftlichen Mitteilung wurde mir empfohlen, die Ablehnungsgründe telefonisch abzufragen, was ich auch tat. Die Antworten waren aber nichtssagend: Es wurden formale Gründe genannt (der Antrag sei zu lang; der Antrag sei teilweise zu deskriptiv). Als wesentlicher Grund wurde jedoch auf eine zu niedrige Priorität in einem wie auch immer gearteten Vorbegutachtungsverfahren hingewiesen.

Ich möchte erwähnen, dass die Stiftung äußerst detaillierte Projektbeschreibungen einfordert. Es müssen beispielsweise ein bewilligter Tierversuchsantrag oder ein von der Ethikkommission genehmigter Antrag vorliegen. Die Vorbereitung solcher Anträge ist zeitraubend und relativ teuer.

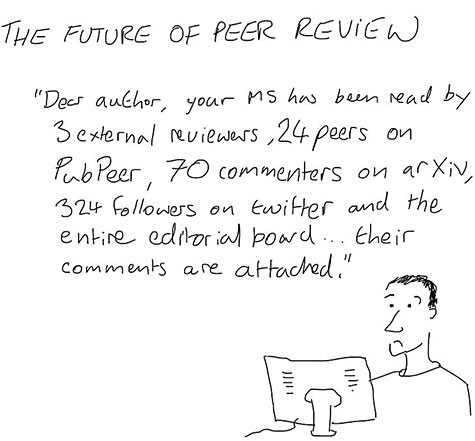

Es wäre interessant zu erfahren, wie das Begutachtungsverfahren bei der Stiftung strukturiert ist. Bei der DFG ist dies mittlerweile absolut transparent und nachvollziehbar. Es werden ausführliche schriftliche Gutachten verschickt, die die Empfehlungen des zuständigen Panels (deren Mitglieder demokratisch gewählt werden und namentlich auf der Homepage erscheinen) beinhalten.

Es wäre schade, falls die Else Kröner-Fresenius-Stiftung ihre Mittel unabhängig von den üblichen Vorgaben der Peer-Review-Praxis verteilen würde und stattdessen einem nicht definierten „Bauchgefühl“ anonymer Gutachter folgt. In Zeiten knapper Ressourcen sollte dies bei einer finanzstarken Stiftung vermieden werden.

Ich würde mich sehr freuen, falls Sie dieser Frage nachgehen könnten und dadurch weiteren Antragstellern ähnlicher Ärger eventuell erspart werden könnte.

Möchte dazu jemand weitere Erfahrungen mitteilen? Entweder direkt im Kommentarfenster unten oder direkt an redaktion@laborjournal.de.

Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden.

Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden. Gerade am Telefon folgende interessante Geschichte gehört:

Gerade am Telefon folgende interessante Geschichte gehört:

Mick Watson

Mick Watson Auf

Auf

Gestern erschien nach über zweimonatiger scharfer Kontroverse das angekündigte Paper zur Genom-Entschlüsselung des legendären nordamerikanischen Waldmenschen, bekannt als „Bigfoot“ oder „Sasquatch“. Dies allerdings unter höchst zweifelhaften Umständen. Erstautorin Melba Ketchum veröffentlichte die Studie als

Gestern erschien nach über zweimonatiger scharfer Kontroverse das angekündigte Paper zur Genom-Entschlüsselung des legendären nordamerikanischen Waldmenschen, bekannt als „Bigfoot“ oder „Sasquatch“. Dies allerdings unter höchst zweifelhaften Umständen. Erstautorin Melba Ketchum veröffentlichte die Studie als

Seid kritisch mit „Invited Commentaries“!

6. Dezember 2013 von LaborjournalNicht nur Nature bringt wöchentlich seine “News & Views”, oder Science seine “Perspectives” — nein, inzwischen präsentieren auch viele, viele andere Journals unter jeweils eigenen Rubriknamen sogenannte “Invited Commentaries”. Kurz gesagt, schicken dafür die Editoren die ihrer Meinung nach heißesten Originalpaper jeder einzelnen Ausgabe vorab an ausgewählte „Experten“ und bitten diese die darin vorgestellten Ergebnisse hinsichtlich ihrer Bedeutung für das gesamte Feld zu kommentieren.

Diese Kommentare sind meist durchaus nett und gewinnbringend zu lesen — insbesondere auch für den Forscher, der gerne mal ein wenig über den Tellerrand schaut. Schließlich liefert solch ein Kommentar in der Regel einen knackigen und kompetenten Überblick über das gesamte Feld, präsentiert dazu die aktuell offenen Fragen und Probleme, ordnet die frischen Ergebnisse des neuen Papers samt Bewertung in diesen Rahmen ein — und wagt zudem noch einen Ausblick, welche weiteren Fragen durch die neuen Erkenntnisse nun womöglich leichter angegangen werden könnten.

Viele Autoren werten es daher als eine Art „Ritterschlag“ ihres Papers, wenn dieses durch einen „Eingeladenen Kommentar“ quasi geadelt wird. Allerdings sind solche „Invited Commentaries“ offenbar manchmal doch eher ein Quell des Ärgernisses für die Autoren des kommentierten Papers. Diesen Beitrag weiterlesen »

Schlagworte: Autor, Invited Commentary, Kommentar, News & Views, Paper, Peer Review, Post-Publication-Peer-Review

Veröffentlicht in Allgemeines, Publikationswesen | Keine Kommentare »