Schon länger hat man den Eindruck, die Diskussionen über eine Reform oder Alternativen zum Peer-Review-System treten auf der Stelle. Dabei wird wohl kaum jemand bestreiten, dass der Peer Review ein Kernproblem beherbergt, das trivialer klingt, als es ist – und zwar unabhängig davon, ob es sich um den klassischen Pre- oder um Post-Publikation-Peer-Review handelt: Er funktioniert nur, wo es auch wirkliche Peers gibt.

Kann das in den Wissenschaften überhaupt nahtlos der Fall sein? Gibt es tatsächlich immer und überall solche „ebenbürtige Experten“? Ganz sicher nicht.

Fragen wir daher zunächst einmal: Wer ist „Experte“? Klar – jemand, der sich in einem bestimmten Gebiet besonders gut auskennt. Was zunächst bedeutet, dass ein Peer vor allem den Status quo eines Gebietes umfassend kennt; womöglich hat er bei dessen Etablierung sogar entscheidend mitgeholfen.

Jetzt geht es aber in der Wissenschaft nicht nur um den Status quo – es geht nicht mal vor allem um den Status quo. Vor allem geht es in der Wissenschaft um das, was jenseits des Status quo liegt. Neue Pfade beschreiten, Licht ins Dunkel bringen, Horizonte erweitern, zu neuen Ufern aufbrechen – das sind die Metaphern, die beschreiben, was vor allem Ziel der Wissenschaft ist. Oder, schlichter formuliert: neue Erkenntnisse gewinnen.

Das Paradoxon dabei ist nun, dass es da, wo einer erstmals Neuland beschreitet, keine Experten geben kann. Das heißt zwar nicht, dass jeder Experte des Status quo grundsätzlich nicht mehr adäquat bewerten kann, was er von jenseits der bekannten Grenzen seines Gebietes zu hören bekommt. Aber es ist natürlich ungleich schwieriger zu beurteilen, ob jemand tatsächlich Handfestes oder eben nur Blödsinn aus absolutem Neuland berichtet. Und da die Experten des Status quo auch gerne Bewahrer des Status quo sind, kippen sie schon öfter mal das Kind mit dem Bade aus, wenn sie vermeintlich allzu abenteuerliche Berichte abschmettern.

Beispiele gibt es genug, wie letztlich richtige Ergebnisse und Schlussfolgerungen aus totalem wissenschaftlichem Neuland sehr lange brauchten, um sich gegen den „Experten“-Mainstream durchzusetzen: Barbara McClintocks springende Gene, Stanley Prusiners Prionen, Lynn Margulis und die Endosymbiontentheorie, Günter Blobels Signalpeptide, die Helicobacter-Geschichte,… – alles Fälle, bei denen die Peers seinerzeit schlichtweg unfähig oder unwillig waren, grundlegend Neues und Richtiges zu erkennen.

Nicht zuletzt deshalb zog der englische Soziologe Steve Fuller das Fazit: „Peer Review funktioniert bei ‚normaler Wissenschaft‘, hat aber auch die Macht radikale Ideen zu unterdrücken.“

Ralf Neumann

(Foto: fona.com)

Can tweets be used to detect problems early with scientific papers? A case study of three retracted COVID-19/SARS-CoV-2 papers – so lautet der Titel eines

Can tweets be used to detect problems early with scientific papers? A case study of three retracted COVID-19/SARS-CoV-2 papers – so lautet der Titel eines

Früher hieß es: Es ist publiziert, also stimmt es! Oft beendete man noch jegliche kritische Diskussion mit den Argumenten des Peer-Review und des Journal-Impaktfaktors. Den Grund dafür, dass publizierte Versuchsergebnisse im eigenen Labor nicht zu reproduzieren waren, suchte man dann ausschließlich bei sich selbst.

Früher hieß es: Es ist publiziert, also stimmt es! Oft beendete man noch jegliche kritische Diskussion mit den Argumenten des Peer-Review und des Journal-Impaktfaktors. Den Grund dafür, dass publizierte Versuchsergebnisse im eigenen Labor nicht zu reproduzieren waren, suchte man dann ausschließlich bei sich selbst. Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden.

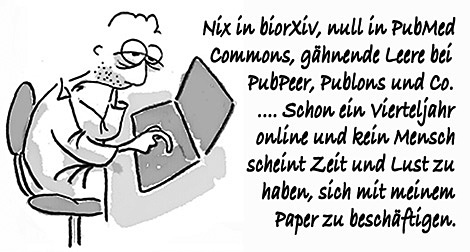

Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden. Gerade eine interessante Diskussion über Post-Publication-Peer-Review mit einem Forscher gehabt, der zugleich auch als Editor eines Journals fungiert. Der war sehr angetan von Preprint-Servern für Manuskripte a la

Gerade eine interessante Diskussion über Post-Publication-Peer-Review mit einem Forscher gehabt, der zugleich auch als Editor eines Journals fungiert. Der war sehr angetan von Preprint-Servern für Manuskripte a la