„Wissenschaftsbetrug ist selten. Stimmt das eigentlich?“ Diese Frage stellte unser „Wissenschaftsnarr“ Anfang des Jahres in seiner Laborjournal-Kolumne (LJ 1-2/2023: 22-24). Und fasste ein Ergebnis seiner Recherche folgendermaßen zusammen:

„Wissenschaftsbetrug ist selten. Stimmt das eigentlich?“ Diese Frage stellte unser „Wissenschaftsnarr“ Anfang des Jahres in seiner Laborjournal-Kolumne (LJ 1-2/2023: 22-24). Und fasste ein Ergebnis seiner Recherche folgendermaßen zusammen:

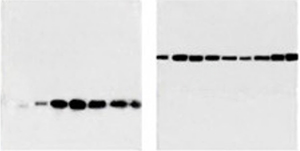

Beispielsweise können mittlerweile wissenschaftliche Abbildungen automatisiert auf Manipulationen untersucht werden. Und tatsächlich zeigt die Anwendung dieser Techniken, dass mehr als vier Prozent aller biomedizinischen Publikationen Graphen und Abbildungen enthalten, die hochgradig verdächtig auf maligne Manipulationen sind – etwa die Verschiebung von Banden, Duplikationen, nicht plausible Fehlerbalken und so weiter. Diese Zahlen werden auch durch Arbeiten bestätigt, in denen Menschen die Abbildungen untersuchten.

Vier Prozent ist nicht selten. Noch schlimmer aber ist, dass in der Zwischenzeit weitere „Stichproben“ auf höhere Quoten kommen. So untersuchte beispielsweise ein fünfköpfiges Team der Universität Birmingham in Alabama, USA, insgesamt 67 Publikationen aus der rhinologischen Forschung mit dem KI-basierten Software-Tool Imagetwin auf potenziell unlauter duplizierte Immunofluoreszenz-Abbildungen (Int. Forum Allergy Rhinol., doi.org/ks6m). Bei 18 Artikeln schlug Imagetwin Alarm. In neun davon charakterisierten die Autoren die Duplikationen daraufhin als „definitiv“, hinsichtlich der übrigen neun blieben sie bei „möglich, aber nicht vollends bestätigt“. Nimmt man nur erstere, bleibt folglich eine Manipulations-Quote von 12 Prozent. Diesen Beitrag weiterlesen »