Schon seit einiger Zeit hat die Produktion gefälschter Bilder in Forschungsartikeln rapide zugenommen. Sogenannte Deepfakes könnten das Problem jedoch noch erheblich verschärfen. Dabei werden Bilder nicht mehr manuell im Computer manipuliert, sondern von Grund auf mithilfe Künstlicher Intelligenz (KI) erzeugt.

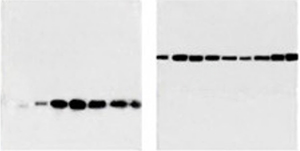

Deepfake-Blots (aus Wang L. et al., Patterns 3; doi: 10.1016/j.patter.2022.100509).

Vier Forscher der chinesischen Universität Xiamen machten jetzt die Probe aufs Exempel: Sie erstellten via KI Fälschungen von Abbildungen, wie sie typischerweise in wissenschaftlichen Zeitschriften vorkommen, und legten diese einer Reihe von Experten vor. Das ernüchternde Ergebnis: Die Fälschungen waren leicht zu erstellen und praktisch nicht als solche zu erkennen (Patterns 3; doi: 10.1016/j.patter.2022.100509) .

Wie bei Deepfakes oftmals üblich, erzeugten die Chinesen einige ihrer Bilder mit Hilfe eines generativen adversen Netzwerks (GAN). Dabei versuchen zwei Systeme – eines als Generator, das andere als Diskriminator – sich gegenseitig bei der Erstellung eines gewünschten Bildes zu übertreffen. Prinzipiell startet der Generator damit, ein gefälschtes Bild aus weißem Rauschen zu erzeugen, beispielsweise ein Gesicht. Natürlich weiß dieser anfangs nicht, wie er ein Gesicht erzeugen soll – also nimmt er die Hilfe eines Diskriminators in Anspruch, der parallel zu unterscheiden lernt, ob ein Bild echt oder gefälscht ist. Auf diese Weise lernt mit der Zeit auch der Generator immer mehr dazu – bis er am Ende den Diskriminator derart täuscht, dass dieser seine Bilder für echt hält. Mit diesem Ansatz wurden beispielsweise bereits verblüffend realistische Bilder von menschlichen Gesichtern produziert – ohne jegliche Vorlage.

Für ihre Studie hingegen erzeugten die Chinesen nun KI-Bilder von Western Blots sowie von Speiseröhrenkrebs (siehe Abbildung) – und legten sie Experten zur Begutachtung vor. Was dabei bezüglich der Western Blots herauskam, beschreiben sie in ihrem Paper wie folgt:

In einem subjektiven Test baten wir drei ausgewiesene Biomediziner, die Qualität der erzeugten Western-Blot-Bilder zu bewerten. Dazu wurde den Probanden eine Reihe von Bildgruppen gezeigt, wobei jede Gruppe drei echte Bilder und ein gefälschtes Bild in zufälliger Reihenfolge enthielt. Die Probanden wurden dann gebeten, das gefälschte Bild zu identifizieren. Zwei der Experten erreichten eine Genauigkeit von 10 bzw. 30 Prozent – was bedeutet, dass sie bei der Identifizierung der gefälschten Western-Blot-Bilder, die mit GAN erzeugt wurden, nicht besser abschnitten als mit zufälligem Raten. Der dritte Experte erreichte eine Genauigkeit von 60 Prozent, da er einen subtilen Unterschied zwischen echten und gefälschten Western-Blot-Bildern erkannte: Bei synthetischen Blots verlief die Grenze zwischen den Blot-Banden und dem Hintergrund nicht ganz so gleichmäßig wie bei echten Blots. Dies jedoch liegt an intrinsischen Eigenschaften von GAN-basierten Methoden und kann durch weitere Optimierung des Netzwerkmodells behoben werden.

Wie gut das KI-Netzwerk hingegen die Bilder vom Speiseröhrenkrebs hinbekam, lassen wir unserer Leserinnen und Leser hier selbst beurteilen:

Drei rein KI-generierte Speiseröhren-Bilder (aus Wang L. et al., Patterns 3; doi: 10.1016/j.patter.2022.100509).

Gänzlich unerwartet kommen diese Ergebnisse jedoch nicht. Denn angesichts dessen, was man mit Deepfake schon an anderen Bildern hingekriegt hat, war eigentlich klar, dass man auch solche, sicherlich banalere biologische Bilder damit erzeugen kann. Die drängende Frage lautet daher: Inwieweit ist die wissenschaftliche Literatur bereits mit KI-generierten Bildern infiltriert? Keiner weiß es, auch die chinesischen Autoren nicht.

Und wie sieht es mit der Aufdeckung solcher KI-generierter Manipulationen aus? Nicht gut, wie die Autoren bemerken:

Da es sich bei den gefälschten Bildern nicht um Duplikate bestehender Bilder handelt, werden herkömmliche rechnergestützte Verfahren zur Erkennung von Bildduplikaten bei ihnen vermutlich versagen.

Die Gefahr ist also groß, dass aufgrund der Möglichkeiten solcher KI-gestützten Deepfakes künftig noch mehr manipulierte Paper die wissenschaftliche Literatur verseuchen. Zumal sie es einem nochmals leichter machen, Forschungsarbeiten zu veröffentlichen, ohne jemals ein echtes Experiment gemacht zu haben. Die berüchtigten Paper Mills lassen grüßen …

Die Chinesen beschließen denn auch ihr Paper mit den Sätzen:

Deepfake ist ein gutes Beispiel für den Missbrauch von KI-Technologien. So haben wir hier gezeigt, dass Deepfake als neues Werkzeug zur Bildfälschung eingesetzt werden kann – und dass die daraus resultierenden Bilder in Veröffentlichungen leicht die bestehenden Aufdeckungsmaßnahmen umgehen können. Daher müssen sowohl aus politischer als auch aus technischer Sicht Präventivmaßnahmen entwickelt und umgesetzt werden, bevor Integrität und Ruf der Wissenschaft Schaden nehmen.

Wie diese konkret aussehen könnten? Im Gespräch mit Chemistry World benennt die weithin bekannte „Bildmanipulations-Detektivin“ Elisabeth Bik – wieder einmal – die Schieflage des wissenschaftlichen Belohnungs- und Reputationssystems als Wurzel all diesen Übels:

Ich glaube, wir sind an einem Punkt angelangt, an dem wir nicht mehr erkennen können, ob eine Arbeit echt oder gefälscht ist. Wir Forschende müssen daher stärker mit den Institutionen zusammenarbeiten, damit sie ihren Teil der Verantwortung übernehmen. Vor allem müssen sie insofern den Druck von den Forschenden nehmen, dass deren gesamte Karriere nicht mehr ausschließlich von der Veröffentlichung in internationalen Zeitschriften abhängt.

Sicher, wenn Veröffentlichungen nicht mehr den massiv überhöhten Stellenwert für die wissenschaftliche Karriere haben, wie es gerade der Fall ist, schwindet gleichsam die Motivation, sich durch unlauteres Treiben immer mehr und immer besser platzierte Artikel zu ermogeln. Das allerdings gilt generell – und somit auch für sämtliche bereits bekannten Arten von betrügerischer Manipulation des Veröffentlichungs-Impacts. Egal, ob man dafür KI missbraucht oder nicht.

Ralf Neumann

Schlagworte: Bildmanipulation, Datenmanipulation, Deepfake, Fake, Integrität, KI, Künstliche Intelligenz, Reputationssystem, Western Blot, wissenschaftliches Fehlverhalten