Akribische Datensammler

Produktübersicht: High-Content-Screening-Systeme

Alle Produkte im Überblick

Mikroskopische Aufnahmen von Zellen liefern eine schier unendliche Fülle biologischer Informationen. Heben lässt sich dieser Datenschatz jedoch nur mit automatischen Systemen, die ganz genau hingucken.

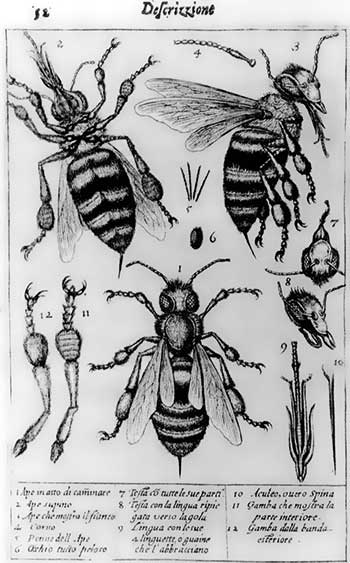

Ob das italienische Universalgenie Galileo Galilei Anfang des 17. Jahrhunderts das erste Mikroskop zusammenbastelte oder der Holländische Brillenmacher Zacharias Jansen, ist unter Wissenschaftshistorikern umstritten. Ziemlich sicher ist jedoch, dass Galileos Landsmann Francesco Stelluti, der wie Galileo dem römischen Naturforscher-Verein „Accademia dei Lincei“ angehörte, die ersten Zeichnungen von mikroskopierten Objekten anfertigte. Bereits im Jahr 1625 veröffentlichte er ein Flugblatt mit Mikroskop-Bildern von Bienen, die er mit einem von Galileo konstruierten Mikroskop untersucht hatte. Noch heute erstaunt der hohe Informationsgehalt der Bienen-Darstellungen auf denen jede Kleinigkeit der Bienen-Anatomie sowie viele phänotypische Details des Bienenkörpers, etwa von Facettenaugen, Kauwerkzeugen (Mandibeln), Antennen oder Flügeln zu sehen sind (siehe Abbildung).

Auch lange Zeit nach Stelluti waren Mikroskopiker auf die Schärfe ihrer Augen und die Fähigkeit ihres Gehirns, Bilddaten exakt einzuordnen, angewiesen. Und bis heute sind das Auge und die Erfahrung eines Experten bei der Analyse einzelner Zellparameter, etwa der Morphologie, schwer zu toppen. Schwierig wird es, wenn der Betrachter sehr viele einzelne Zelldetails gleichzeitig erfassen, beurteilen sowie speichern muss – und dies nicht nur bei einigen wenigen Mikroskopaufnahmen, sondern bei vielen tausenden. Diese Herkules-Aufgabe überlassen Forscher lieber automatischen Mikroskopkameras und Bildanalyseprogrammen in sogenannten High-Content-Screening (HCS)-Systemen (synonym mit High-Content-Imaging oder Analyse-System).

Bildbasierte HCS-Systeme lehnen sich entweder an klassische Weitfeld- sowie konfokale Fluoreszenzmikroskope an, die mit zusätzlichen Modulen für die automatische Bildaufnahme und -auswertung fit gemacht wurden; oder kommen als spezielle HCS-Geräte daher, die auf den ersten Blick nicht als Mikroskope zu erkennen sind. Die optische Einheit versteckt sich hier hinter einem Blechgehäuse, das die Instrumente wie überdimensionale Scanner aussehen lässt.

Beide Spielarten sind jedoch nach dem gleichen Prinzip aufgebaut und enthalten vier wesentliche Bausteine: ein optisches System, einen automatisch angetriebenen, präzise gesteuerten Objekttisch, eine Kamera, welche die Bildsignale empfängt, sowie ein intelligentes Bildverarbeitungsprogramm, das aus dem Wirrwarr der Bilddaten die relevanten Informationen heraus pickt.

In den optischen Systemen dienen Laser, verschiedenfarbige LED-Lampen oder Quecksilberlampen, die ein kontinuierliches Spektrum abstrahlen, als Lichtquellen. Die Lichtstrahlen passieren in Spinnig-Disc-HCS-Geräten zunächst die spiralförmig angeordneten Löcher einer mit hoher Geschwindigkeit rotierenden Nipkow-Scheibe, bevor sie auf die Proben treffen. Wie bei der konfokalen Fluoreszenzmikroskopie blockieren die kleinen Löcher störendes Streulicht und konzentrieren die hindurchtretenden Strahlen auf die Fokusebene des Objekts.

Im Gegensatz zu klassischen konfokalen Mikroskopen, bei denen ein einzelner Lichtstrahl Punkt für Punkt über die Probe geführt wird, fallen durch die Nipkow-Scheibe jedoch viele einzelne Spots gleichzeitig auf die Probe. Dies ermöglicht nicht nur schnelle Bildfrequenzen von über tausend Bildern pro Sekunde und damit verkürzte Aufnahmezeiten. Auch die Strahlenbelastung ist deutlich geringer, weil die Intensität des Lichts kleiner und die Belichtungsdauer kürzer ist.

Rasend schnelle Bildfrequenzen

In HCS-Mikroskopen sind in der Regel Objektive mit hoher numerischer Apertur eingebaut, die für eine maximale Lichausbeute sorgen. Auch auf den Öl-Immersions-Trick, mit dem sich der Brechungsindex des Mediums und damit die Auflösung des Mikroskops erhöhen lässt, verzichten die wenigsten Hersteller. Die üblichen in Standardmikroskopen verwendeten Mineralöle sind für HCS-Mikroskope jedoch ungeeignet. Sie würden ein ziemliches Geschmiere verursachen, wenn die Mikrotiterplatten auf dem Objekttisch automatisch von einem Well zum nächsten verschoben werden. HCS-Geräte sind deshalb meist mit Immersions-Objektiven ausgerüstet, die auf Silikonöl oder Wasser abgestimmt sind.

Die Objekttische von HCS-Instrumenten sind für die Aufnahme klassischer Objektträger sowie Mikrotiterplatten mit unterschiedlichsten Bodenformen sowie Well-Anzahlen ausgelegt. Ein automatischer Nanopositionierer verschiebt die Mikrotiterplatten nanometergenau in alle drei Raumrichtungen. Die exakte Fokussierung des Objekts erledigt entweder ein lasergesteuertes Autofokussystem, das die Reflexion eines Laserstrahls am Boden der Mikrotiterplatte ausnützt oder ein softwaregesteuertes, Bild-basiertes Fokussystem. Letzteres orientiert sich an gut erkennbaren Zelleigenschaften, etwa dem mehr oder weniger scharfen Umriss des Zellkerns, um die Fokusebene einzustellen.

Laser-Autofokussysteme sind schnell und genau, dafür aber nicht immer mit den verwendeten Mikrotiterplatten kompatibel. Bild-basierte Systeme arbeiten ebenfalls exakt, vertrödeln durch die aufwendige Rechnerei der Software jedoch kostbare Zeit und bremsen die High-Content-Analyse hierdurch etwas aus.

Bildanalyse-Pipeline

Auch bei den Kameras, welche die optischen Signale des Mikroskops in ein Bild umwandeln, das schließlich auf dem Monitor erscheint, existieren zwei unterschiedliche Systeme: Charge-Coupled-Device (CCD)-Kameras oder neuerdings Electron-Multiply-(EM)CCD-Kameras sowie Complementary-Metal-Oxide-Semiconductor (CMOS)-Kameras. Einige Hersteller, wie zum Beispiel Thermo Fisher, bevorzugen in ihren Systemen CCD-Kameras und begründen dies mit höheren Quantenausbeuten und etwas besseren Signal-zu-Rausch-Verhältnissen im Vergleich zu cMOS-Kameras. Andere Firmen wie Perkin-Elmer favorisieren cMOS-Kameras oder bieten, wie zum Beispiel Molecular Devices, teilweise beide Alternativen an.

Sind die Bilder der Zellen im Kasten, geht es an den kniffligsten Teil des High- Content-Screenings: die Analyse und Aufbereitung der Bild-Rohdaten. Die Geräte-Hersteller liefern hierzu meist ihre firmeneigenen Software-Lösungen. Viele Forscher verwenden aber auch freie Bildanalyse-Programme, wie etwa Cellprofiler oder KNIME, die sie an ihre individuellen HCS-Experimente anpassen.

Freie wie proprietäre Programme folgen einer sogenannten Bildanalyse-Pipeline, die in möglichst kurzer Zeit fehlerfreie, neutral gewichtete Bilddaten liefern soll. Im ersten Schritt der Pipeline eliminiert die Software die gröbsten Schnitzer in den Bildrohdaten, etwa zu hohes Hintergrundrauschen, Artefakte oder störende Belichtungseffekte. Anschließend konzentriert sie sich auf einen Teilausschnitt, der einzelne Zellen enthält. Aus diesem entfernt sie Objekte, die für die weitere Analyse ungeeignet sind, etwa Zellen in Randzonen des analysierten Sektors.

Erst nach dieser Vorauswahl startet das Computergehirn mit der eigentlichen Zellanalyse und erfasst spezifische Zelleigenschaften wie Morphologie, Textur, Lichtstreuung oder emittierte Fluoreszenz. Die hieraus resultierenden Bilddaten werden schließlich normalisiert und graphisch dargestellt, zum Beispiel als Heat Map, Linien- oder Streudiagramm.

Die Pharmaindustrie setzt HCS-Systeme vor allem bei der immer verzweifelteren Suche nach neuen Wirkstoffkandidaten und Leitstrukturen ein, die ihre nur noch spärlich tröpfelnden Drug-Pipelines wiederbeleben sollen. Dabei greifen Pharma-Forscher zunehmend auf klassische phänotypische Assays beziehungsweise Screens zurück, die lange Zeit außer Mode waren und von Zielmolekül-orientierten Ansätzen verdrängt wurden. Die grundlegende Strategie phänotypischer HCS-Screens ist im Grunde simpel: Zunächst entwickeln die Forscher einen Assay, mit dem sie phänotypische Veränderungen in den erkrankten Zellen mit dem HCS-System verfolgen können. Anschließend versetzen sie die Zellproben mit einer Substanzbibliothek und testen, wie die einzelnen Verbindungen der Stoffsammlung den krankheitsbedingten Phänotyp beeinflussen. Substanzen, die sich positiv auswirken, kommen schließlich in die engere Wahl und werden als mögliche Leitstrukturen (Leads) weiter untersucht. Auf welche(s) Zielmolekül(e) die potentiellen Wirkstoffkandidaten einwirken und wie der Wirkmechanismus konkret aussieht, ist hierbei zunächst nebensächlich.

High-Content-Screens sind aber nicht nur für Pharmaforscher interessant. Kombiniert mit aktuellen molekularbiologischen Techniken wie RNAi und CRISPR-Cas eröffnen sie eine riesige Spielwiese für akademische Forscher, die die Funktion ihres Lieblings-Gens respektive -Proteins aufklären wollen.

Kombiverfahren

Eines dieser Verfahren, das HCS und CRISPR-Cas elegant miteinander verbindet, nennt sich Array Library Screening. Bei diesem kultiviert man die zu untersuchenden Zellpopulationen in den getrennten Wells einer Mikrotiterplatte. Die Zellen transfiziert man dann mit Hilfe von Viren, Plasmiden oder Oligos mit verschiedenen single guide RNAs (sgRNAs). Will man gleichzeitig die Wirkung einer Substanzbibliothek auf die CRISP-Cas editierten Zellen testen, gibt man diese ebenfalls hinzu.

Das HCS-Gerät erfasst die Phänotypen der behandelten Zellen Well für Well und ordnet sie den jeweiligen sgRNAs zu. Hat es bei der Bildanalyse nichts übersehen, erhält man so sämtliche sgRNAs, die den gewünschten Phänotypen hervorrufen. Anschließend muss man sich dann „nur noch“ die Zielgene dieser sgRNAs vorknöpfen.

Alle Produkte im Überblick

(Erstveröffentlichung: H. Zähringer, Laborjournal 07/2016, Stand: Juni 2016, alle Angaben ohne Gewähr)

Letzte Änderungen: 12.07.2016