Auf das richtige Werkzeug kommt es an

Webtools, Server und Software für Biologen

Henrik Müller

(08.12.2019) Um der überbordenden Datenflut in den Biowissenschaften Herr zu werden, entwickeln Bioinformatiker wie am Fließband Tools und Plattformen, die Forschern die Datenanalyse erleichtern sollen. Diese setzen zwar meist keine Informatikkenntnisse voraus, ein wenig bioinformatisches Basiswissen schadet aber nicht.

Unter dem Gesichtspunkt der genetischen Komplexität spielt Homo sapiens in der gleichen Liga wie der Fadenwurm, dem knapp 20.000 Gene reichen, um im Boden zu überleben und binnen kurzer Zeit geschlechtsreif zu werden. Immerhin kann sich Homo sapiens damit trösten, dass sein Genom aus weitaus mehr Nukleotiden besteht als das des Wurms: Nur ein Prozent menschlicher Genomsequenzen haben eine Funktion als Gen. Die restlichen 99 Prozent, also schlappe 2,97 Milliarden Basenpaare, enthalten zumeist unbekannte Informationen. Ohne Bioinformatik-Software und umfangreiche Datenbanken ist es nahezu unmöglich, aus diesen die biologisch relevanten Sequenzen herauszufiltern.

Dank fleißiger Bioinformatiker, die als Dolmetscher zwischen den Biodisziplinen fungieren, existieren mittlerweile unzählige Analysewerkzeuge, die von der Genom-Annotation über Ökologie bis hin zur Chemoinformatik reichen. Die Frage ist nur: Wie finde ich im Internet das passende Bioinformatik-Tool, das mich in meiner Fragestellung unterstützt, und wie wende ich es an?

Manche Werkzeuge dienen als reine Informationsquellen, die dabei helfen können, biologische Fragen zu formulieren. So kann man zum Beispiel Roches elektronische Schautafeln des biochemischen Metabolismus (web.expasy.org/pathways) mit geeigneten Stichwörtern durchforsten und Reaktionskomplexe herausfiltern, die für die eigene Arbeit interessant sind. Darüber hinaus sind alle aufgeführten Enzyme direkt mit ExPASys Enzymdatenbank (enzyme.expasy.org) verbunden.

Der Cellosaurus (web.expasy.org/cellosaurus) beschreibt dagegen alle Zelllinien aus Vertebraten und Invertebraten, inklusive Querverweisen und Literaturangaben. Allein 85.532 humane Zelllinien befinden sich darunter. Der Expressions-Atlas (www.ebi.ac.uk/gxa/home) wiederum listet für 64 Tiere, Pflanzen und Pilze auf Basis von 3.500 Studien auf, welche Proteine unter welchen Bedingungen exprimiert werden können.

Rhea (www.rhea-db.org) verzeichnet schließlich knapp 12.500 biochemische Reaktionen samt deren Reaktionsteilnehmer und ist mit verschiedenen Datenquellen verknüpft: Darunter ChEBI (www.ebi.ac.uk/chebi), ein Lexikon aller molekularen Entitäten; UniProtKB (www.uniprot.org), die zentrale Drehscheibe zur Annotation von Enzymen und nicht zuletzt PubMed (www.ncbi.nlm.nih.gov/pubmed), die biomedizinische Meta-Datenbank mit gegenwärtig mehr als dreißig Millionen gelisteten Referenzen.

Mithilfe dieser Datensammlungen fällt es nicht schwer, eigene Hypothesen aufzustellen – die plausibelsten herauszufiltern oder in Hochdurchsatz-Datensätzen Assoziationen zu identifizieren, ist da schon komplizierter. Seit 2016 hilft dabei das Independent Hypothesis Weighting, ein von der Arbeitsgruppe um Wolfgang Huber am Heidelberger EMBL in Nature Methods veröffentlichtes Protokoll zum Filtern statistisch relevanter Befunde (www.bioconductor.org/packages/IHW). Wer sich fernab des Forschungsalltags dagegen einfach nur an der Schönheit zellulären Lebens berauschen möchte, dem seien XVIVOs Animationen empfohlen (xvivo.com/inner-life-of-the-cell/).

Noch vielfältiger als die reinen Wissensquellen sind aber die unzähligen Analysewerkzeuge, darunter viele Klassiker, denen jeder Biowissenschaftler früher oder später begegnet. Die zwanzigjährige Erfolgsgeschichte der Open Source-Visualisierungssoftware PyMol (pymol.org), die 3D-Strukturbilder biologischer Klein- bis Makromoleküle erstellt, ist da nur ein Beispiel. Warren Lyford DeLano zufolge, ihrem früh verstorbenen Erstautor und Advokat frei zugänglicher Software in den Biowissenschaften, wurden mit PyMol bereits vor zehn Jahren mehr als ein Viertel aller publizierten Proteinstrukturbilder erstellt. Das PyMol-Wiki (pymolwiki.org) bietet einen umfassenden Überblick über all seine Funktionen, von der Erstellung von Bildern und Filmen bis hin zu physikochemischer Modellierung.

Software-Urgesteine

Ein Veteran unter den Bioinformatik-Tools ist auch BLAST (blast.ncbi.nlm.nih.gov/). Vor der Jahrtausendwende war das Basic Local Alignment Search Tool die meistzitierte Publikation in den Biowissenschaften und rangiert noch immer auf Platz zwölf von Natures Top-Hundert-Publikationen. BLASTs heuristischer Algorithmus vergleicht Ähnlichkeiten von Nukleotid- und Aminosäuresequenzen auf ihre statistische Signifikanz – mittlerweile als Teil einer Familie von einem Dutzend spezialisierter BLAST-Algorithmen (ftp.ncbi.nlm.nih.gov/pub/factsheets/HowTo_BLASTGuide.pdf). Hinter der Kulisse vieler Webportale lokalisieren die BLAST-Algorithmen Domänen, identifizieren Spezies-Zugehörigkeiten, etablieren Phylogenien oder stellen inzwischen ganze Genome einander gegenüber. Gegenwärtig noch ein wenig erfolgreicher im Kampf um Zitationen ist nur BLASTs großer Konkurrent CLUSTALW (www.clustal.org).

Das laut Google Scholar weltweit meistzitierte Bioinformatik-Werkzeug ist aber das in der Gruppe von Björn Usadel an der RWTH Aachen und dem Forschungszentrum Jülich entwickelte Trimmomatic (usadellab.org). Wie bereits der Name verrät, trimmt es automatisch Sequenzierdaten. Der Goldstandard des Next-Generation-Sequencing ist die Short-read-RNA-Sequenzierung von Illumina. Diese amplifiziert aber auch Vektorsequenzen, Poly(A)-Schwänze und Introns, woraus Sequenzierfehler resultieren, zum Beispiel in der Nähe der Primer-Bindestellen oder am Ende langer Sequenzen. Trimmomatic befreit die Sequenzdaten von diesen Artefakten und erleichtert hierdurch die Sequenz-Rekonstruktion aus den zweihundert Basenpaaren langen Short-read-Fragmenten.

Diese Standard-Tools kennt jeder Biowissenschaftler, wenngleich man in entsprechenden Wikis manchmal auch weniger bekannte Anwendungen dieser beliebten Werkzeuge finden kann. Nicht auf dem Radar haben Biologen aber oftmals die vielen speziellen Tools für biowissenschaftliche Teildisziplinen.

Oliver Kohlbacher, Professor für Bioinformatik an der Eberhard Karls Universität Tübingen empfiehlt deshalb: „Am besten ist es, mit Bioinformatik-Kollegen zu sprechen und mit ihnen zu kooperieren. An vielen Standorten gibt es darüber hinaus zentrale Bioinformatik-Serviceeinrichtungen, hier in Tübingen zum Beispiel das Quantitative Biology Center (QBiC), deren festangestellte Mitarbeiter Bioinformatik-Fragestellungen als Service gegen Bezahlung abwickeln. Die dritte Option ist zu lernen, die Daten selbst zu analysieren. Das ist am aufwendigsten, aber sicherlich auch am nachhaltigsten.“

Ein guter Startpunkt hierfür ist das Werkzeugportal Expert Protein Analysis System (ExPASy) des Schweizer Instituts für Bioinformatik (expasy.org). Der ExPASy-Server stellt zahlreiche Programme bereit, etwa für Proteomik, Genomik, Transkriptomik, Systembiologie, Populationsgenetik und Medikamentendesign. Mit 233 gelisteten Tools und 37 Datenbanken ist die Proteomik am stärksten vertreten. Aber auch zur Analyse von Organismen und Populationen werden ein knappes Dutzend Datenbanken und doppelt so viele Tools angeboten. Dank einer einfachen Stichwortsuche finden sich auf dem Portal auch gelegentliche Nutzer zurecht.

Werkzeug-Sammlungen

Natürlich versuchen nicht nur die Schweizer Bioinformatiker, die unzähligen Analyse-Werkzeuge zu strukturieren. Die Fachgruppe Bioinformatik Deutschland, die mehrere wissenschaftliche Gesellschaften mit aktuell über tausend Mitgliedern vereint, fasst alle wichtigen Werkzeugportale unter www.bioinformatik.de zusammen. Aufgeführt sind unter anderem die Portale des Deutschen Netzwerks für Bioinformatik-Infrastruktur (de.NBI; www.denbi.de/services), des European Bioinformatics Institute (EMBL-EBI, www.ebi.ac.uk/services) sowie des National Center for Biotechnology Information (NCBI, www.ncbi.nlm.nih.gov/home/analyze).

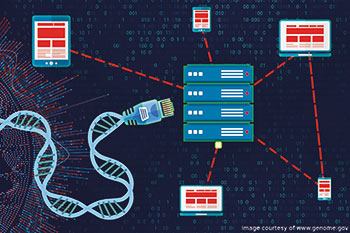

Kohlbacher sieht die vielen Bioinformatik-Tools jedoch mit gemischten Gefühlen: „Web-basierte Tools werden immer populärer. Aber das hat natürlich auch seine Grenzen. Es gibt Dinge, die man über Webseiten schlicht nicht machen kann, weil zum Beispiel ganze Genomdatensätze transferiert werden müssen. Deshalb stellen viele Webseiten, wie das EMBL-EBI, große Datensätze, etwa Sequenzdatenbanken, direkt zur Analyse zur Verfügung.“

Es existieren aber noch weitere Hürden. Wer sensible Informationen wie beispielsweise Patientendaten analysiert, schreckt aus Sicherheitsbedenken davor zurück, Webportale zu benutzen. Und wer die Liste brauchbarer Bioinformatik-Werkzeuge eingegrenzt hat, weiß noch immer nicht, welches Tool für die eigene Fragestellung tatsächlich am geeignetsten ist.

Während ExPASy und EMBL-EBI statische Listen von Datenbanken und Werkzeugen bereitstellen, geht das Open-Source Galaxy-Projekt einige Schritte weiter. Auf den ersten Blick erscheint der seit 2018 in Freiburg betriebene europäische Galaxy-Server (usegalaxy.eu) wie eine weitere Sammlung nützlicher Programme. Und natürlich kann er auch so verwendet werden – dank 250 GB-Datenspeicher pro Benutzer in der de.NBI-Cloud und zusätzlichen Rechenkapazitäten des Freiburger Supercomputers Nemo sogar recht großzügig.

Björn Grüning, technischer Kopf des Galaxy-Servers und Postdoktorand in der Arbeitsgruppe von Rolf Backofen am Institut für Informatik der Universität Freiburg, erklärt aber: „Das Galaxy-Framework ist viel mehr als ein Online-Werkzeug-Portal. Erstmal findet sich unter unseren 2.000 Werkzeugen wirklich alles, von der Präprozessierung, also der Frage, wie gut Daten überhaupt zu einer bestimmten Fragestellung passen, bis hin zur Visualisierung der Ergebnisse und Plot-Generierung. Natürlich kann aber kein Tool alles. Statt sich diese stückchenweise zusammenzusuchen, und sich Sorgen um Datenkonvertierung et cetera machen zu müssen, kann man einzelne Werkzeuge im Galaxy-Framework zu sogenannten Workflows verbinden, die automatisch abgearbeitet werden. Aktuell sind bereits 16.270 Workflows gespeichert. Auch externe Webservices lassen sich im interaktiven Galaxy-Framework implementieren. Jeder Benutzer erhält, falls gewünscht, quasi seine eigene Entwicklungsumgebung und benötigt dazu keine Programmierkenntnisse.“

Genauere Informationen hierzu erhält man im Galaxy-Training-Netzwerk oder in einem Paper des Galaxy-Teams (Cell Syst. 6(6): 752-58).

Wachsende Galaxy-Gemeinde

Wie gut der deutsche Galaxy-Server angenommen wird, zeigen seine europäischen Nutzungsdaten. 1.650 von gegenwärtig 9.884 registrierten Benutzern nahmen im zurückliegenden Oktober seine Dienste in Anspruch, und zwar mit knapp 200.000 Einzelaufträgen. Jeden Monat registrieren sich fünfhundert bis sechshundert neue User. Die Werkzeuge kann man aber auch ohne Registrierung verwenden. Als Kooperationspartner in der Europäischen Infrastruktur-Initiative für Biologische Information (ELIXIR) können Galaxy-Nutzer sogar brach liegende Rechenleistung europäischer Partner anzapfen. Kapazitätsgrenzen dürften so schnell also nicht erreicht werden.

Und Grüning setzt noch einen drauf: „Wer Sicherheitsbedenken hat, weil er in der Industrie forscht oder klinische Daten analysiert, kann präparierte Workflows inklusive aller notwendigen Tools und Tutorials als Container herunterladen und hinter der eigenen Firewall rechnen lassen. Sensible Daten verlassen so nie die eigene Festplatte. Und dennoch können alle Tools der Galaxy-Community verwendet werden.“

Die Problematik, erstmal das passende Programm zu finden, versteht natürlich auch Grüning: „Empfehlungen zu beliebtesten Tools auszusprechen, ist schwer. Je nach Wissenschaftsgemeinde sind das komplett andere Software-Programme. Was die einzelnen Disziplinen für gut erachten, spiegelt sich aber in Tools wider, die gut dokumentiert sind, regelmäßig aktualisiert werden und in Workshops auftauchen.“

Wer sich quantitativere Aussagen wünscht, darf sich bei Anup Kumar vom Freiburger Galaxy Team bedanken – der Doktorand in Backofens Gruppe implementierte im vergangenen Sommer ein Empfehlungssystem. Grüning erläutert: „Wenn ein Anwender einen bestimmten Datensatz hochlädt, kann unser Galaxy-Server Empfehlungen aussprechen, welche Tools früheren Usern für ähnliche Aufgaben bevorzugt haben. Benutzern geben wir damit die Chance, explorative Forschung zu betreiben, was es den jeweiligen Wissenschaftsgemeinden ermöglicht, die besten Tools interaktiv zu finden.“

Die Übersichtlichkeit des Galaxy-Projekts fördern Grüning und Co. auch auf Server-Ebene: „Zusätzlich zu unserer traditionellen Genomik-Ausrichtung widmen wir sechzehn Forschungsdisziplinen gegenwärtig eigene Subdomains, die nur jeweils relevante Werkzeuge enthalten, wie zum Beispiel plants.usegalaxy.eu, rna.usegalaxy.eu und singlecell.usegalaxy.eu. Wir stellen die technische Verlässlichkeit und Gebrauchstauglichkeit aller Tools sicher, den Inhalt liefern die Entwickler der einzelnen Wissenschaftsgemeinden selbst. Darüber hinaus können sich Forscher dort fachspezifisch organisieren, ihre eigene Startseite erstellen und relevante Veranstaltungen posten.“

Für jeden etwas dabei

Grünings Zukunftsvision reicht aber noch weiter: „Galaxy ist ein Multi-User-System. Auf unserer Plattform können sich Endanwender aller möglichen Omics-Tools treffen, miteinander interagieren, ihre Daten, Analysen und Ergebnisse teilen und direkt voneinander lernen – ohne Monate auf statische Publikationen warten zu müssen. Das reicht von Arbeitsbesprechungen innerhalb der eigenen Forschungsgruppe bis hin zu internationalen Kooperationen. Auch Datensätze und Software-Tools müssen als honorierungswürdig anerkannt werden. Schließlich fließt in ihre Erstellung mehr Geld und Hirnschmalz als in das Schreiben einer Publikation. Aktuell sehen wir das zum Beispiel bei den Ökologen und Klimaforschern auf der Galaxy-Plattform. Seit einem halben Jahr tauschen Wissenschaftler dieser beiden Disziplinen vermehrt Tools aus und arbeiten tatsächlich zusammen, um ihre Workflows effizienter zu machen und mehr Wissen aus ihnen zu extrahieren. Da Datenanalysen detailliert mit jeweiliger Werkzeug-Version, jedem einzelnen Parameter et cetera geteilt werden können, sind Verlässlichkeit, Transparenz und Reproduzierbarkeit dem momentanen Stand weit voraus.“

Bei Fragen stehen neben dem Freiburger Galaxy-Team auch eine Mailing-Liste und ein Online-Community-Hub bereit.

Nicht in die Irre führen lassen

„Einen Königsweg in die Bioinformatik gibt es nicht“, warnt indes Kohlbacher. „Derartige Server bringen Tools natürlich einfacher an den Mann und an die Frau. Für komplexe Aufgaben gibt es aber natürlich nicht nur ein Tool oder einen Workflow, der mit einem Knopfdruck alle Fragen beantwortet. Weshalb es leicht in die Irre führen kann, wenn man nicht versteht, was sich hinter den Kulissen der Programme abspielt; welches die Implikationen einzelner Parameter sind und ob die eigenen Daten überhaupt die Erfordernisse dafür mitbringen. Eine schöne Web-Oberfläche reduziert zwar die Kontaktangst, aber sie vertieft ja nicht das Verständnis. Auch hier gilt nun mal das Prinzip: Garbage in, garbage out.“

Eines ist für Kohlbacher, der die Fachgruppe Bioinformatik Deutschland seit 2018 als Sprecher vertritt, deshalb klar: „Lebenswissenschaften kann man nicht länger studieren, ohne ein Minimum an Bioinformatik-Kenntnissen zu haben. In Zeiten von Terabytes an Hochdurchsatzdaten muss Bioinformatik genauso wie Pipettieren in die Ausbildung und in den Berufsalltag eines Lebenswissenschaftlers integriert werden. Deshalb bieten wir sehr bewusst Kurse für Biowissenschaftler und Mediziner an, auch unabhängig von Pflichtveranstaltungen im Studium.“

Entsprechend reichhaltig ist das Angebot an Trainingskursen. Selbst wenn die eigene Reisefreude nicht so ausgeprägt ist, bieten de.NBI (www.denbi.de/training), EMBL-EBI (www.ebi.ac.uk/training) und NCBI (www.ncbi.nlm.nih.gov/home/tutorials/) neben regelmäßigen Weiterbildungsveranstaltungen vor Ort auch Online-Kurse und Videomaterialien an. Eine aktuelle Auswertung dieser Angebote finden Sie in einer F1000Research-Publikation (8(ELIXIR):1877).

Interaktive Trainingslager

Auch das Galaxy-Projekt koppelt ihre Web-basierte Analyse-Umgebung ganz bewusst an eine stetig wachsende eLearning-Sammlung interaktiver Tutorials. Das Ziel ist letztendlich, Biomedizinern und Wissenschaftlern den Weg zu bereiten, Daten selbstständig bioinformatisch zu analysieren (training.galaxyproject.org).

Björn Grüning hat dazu eine Anekdote parat: „Einer der ersten Teilnehmer unserer einwöchigen Workshops für dreißig bis vierzig Leute vor fünf oder sechs Jahren hat mit den erlernten Tools innerhalb von zwei Jahren in Nature Communications veröffentlicht. Vor zwei Jahren hat er dann das erste Mal selbst diesen Workshop gegeben und in diesem November eine Professur in Frankfurt angetreten. Zur Nutzung unserer Bioinformatik-Tools weiß er mittlerweile genauso viel wie wir!“

„Doch von Trainingsveranstaltungen profitieren nicht nur Endnutzer“, ergänzt Kohlbacher. „Um die Tools weiter zu optimieren, beobachten wir in Workshops sehr genau, in welchen Fallstricken sich die Kursteilnehmer verheddern. Das erlaubt es uns maßgeblich, unsere Tools auf die Ansprüche der Nutzer abzustimmen. Deshalb verdonnere ich meine Tool-Entwickler immer dazu, auch Kurse zu geben, um möglichst schon Feedback zu bekommen, bevor unsere Software öffentlich verwendet wird.“

Was in Zukunft eingesetzt werden wird, spiegelt unter anderem der diesjährige Dissertationspreis der Fachgruppe Bioinformatik wider. Jedes Jahr wird er auf der German Conference on Bioinformatics verliehen – der weltweit ältesten, regelmäßig stattfindenden Bioinformatik-Tagung (www.gcb2020.de).

Maschinelles Lernen

Dieses Jahr ging der Preis an Kai Dührkop aus der Arbeitsgruppe von Sebastian Böcker, Lehrstuhlinhaber für Bioinformatik an der Friedrich-Schiller-Universität Jena. Dührkop entwickelte mit seinen Kollegen eine Methode zur raschen Identifikation der molekularen Formeln und Strukturen von Metaboliten auf der Basis von Tandem-MS-Spektren. Bisher mussten Experten diese zeitaufwendig per Hand aufklären. Dührkop und seine Kollegen nutzen dafür sogenannte Support Vector Machines. Dank dieser maschinellen Lernverfahren erstellen sie aus MS-Spektren Fragmentierungs-Bäume, die den Fragmentierungsablauf eines Moleküls im Massenspektrometer widerspiegeln. Anschließend werden diese dann in Strukturdatenbanken Molekülen zugeordnet. Die zugehörige Software findet man unter bio.informatik.uni-jena.de/software/sirius/.

Kohlbacher sieht hier einen größeren Zusammenhang: „Maschinelles Lernen wird in Zukunft aus den Biowissenschaften nicht mehr wegzudenken sein. Next-Generation-Sequencing und Gesamtgenom-Sequenzierung kommen gegenwärtig in der medizinischen Versorgung an und produzieren riesige Datenmengen, die nur mit effektiveren Tools zu bewältigen sind. Ohne neuronale Netze wird das schwer werden.

Übrigens sind es auch medizinische Anwendungen, die die gegenwärtigen Investitionen in translationale Bioinformatik antreiben. Weshalb es auch nicht überrascht, dass in der Medizin neue Bioinformatik-Professuren geschaffen werden – und nicht etwa in der Informatik.“

Eine durchdachte Einführung in die Grundlagen (bio)maschinellen Lernens gibt Anup Kumar unter training.galaxyproject.org/training-material/topics/statistics/.

Bleibt zu hoffen, dass diese Trainingsangebote dazu beitragen, die Arbeit seines Kollegen Grüning zu erleichtern: „Meine Herausforderung besteht aktuell darin, Leute auf den Galaxy-Server aufmerksam zu machen. Ich möchte Forschern nicht mehr auf Konferenzen erklären müssen, dass sie ihre Arbeit der letzten sechs Monate bei uns mit ein paar Klicks in einem Tag hätten erledigen können.“

Letzte Änderungen: 08.11.2019