Was piept denn da?

Hans Zauner

(06.04.2020) SALZBURG: Wenn wir Abfolgen von Tönen hören, macht sich das Gehirn seinen eigenen Reim auf diese Muster. Neurowissenschaftler sind den Mechanismen dieser unbewussten Vorhersagen auf der Spur. Die Studie verspricht auch einen neuen Ansatz zum Verständnis des lästigen Tinnitus.

Unser Sehsinn ist keine Videokamera, und unser Hörsinn ist kein Audio-Rekorder. Denn auch wenn sich diese Vergleiche anbieten, so gibt es doch einen wichtigen Unterschied: Kamera und Tonbandgerät, zumindest solche klassischer Bauart, zeichnen einfallende Bilder und Töne objektiv auf. Das Zusammenspiel unserer Augen und Ohren mit dem Gehirn ist dagegen viel komplizierter – aber auch interessanter. Denn die Signale, die über die Seh- beziehungsweise Hörbahn einlaufen, treffen im Gehirn auf Mechanismen übergeordneter Regionen. Das Gehirn bringt seine gelernten oder angeborenen Erwartungen ein, es trifft Vorhersagen über die einströmenden Daten, und zwar ohne dass der Besitzer des Gehirns etwas davon mitbekommt.

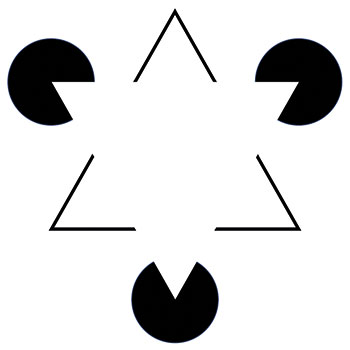

Im Fall des Sehsinns kann man das schön an bekannten optischen Täuschungen zeigen. Eine davon ist das Kanizsa-Dreieck (siehe Abbildung gegenüber). Der Betrachter meint, ein klar umrissenes weißes Dreieck zu erkennen. Aber in Wirklichkeit ist diese geometrische Figur gar nicht da, auf dem Bild sind nur schwarze Linien und Kreissegmente dargestellt. Das weiße Dreieck ist eine Erfindung unseres Gehirns, das offenbar eine Erwartung darüber einspeist, was auf der Abbildung zu sehen sein soll.

In gewisser Weise ähnliche Effekte gibt es auch bei Tönen und Geräuschen. Über die „Hörbahn“, also die Nervenbahnen, die das Ohr mit dem Gehirn verknüpfen, gelangen Reize in den auditorischen Cortex – das ist die Struktur des Gehirns, die in erster Linie Hörreize verarbeitet.

Neben diesen Bottom-up eingespeisten Signalen aus dem Ohr kommen im auditorischen Cortex aber auch Top-down-Prozesse zum Tragen; also Einflüsse, die vom Gehirn selbst kommen und auf die Verarbeitung der Reize einwirken.

Bitte nicht einschlafen!

Nathan Weisz und sein Team am Zentrum für kognitive Neurowissenschaften der Universität Salzburg konnten nun in nicht-invasiven Experimenten am Menschen demonstrieren, wie sehr unbewusste Erwartungen und Vorhersagen des Gehirns auch beim Hören eine Rolle spielen – und dass sich diese Vorhersagen auch konkret auf die Höhe eines Tons beziehen (Nat. Commun. 10: 3440).

Für ihre Studie rekrutierten die Salzburger 34 geduldige Versuchspersonen, die einfach nichts tun durften, während ein stummgeschalteter Film lief. „Wir zeigten ihnen eine Aufführung des Cirque du Soleil, das ist auch ohne Ton ganz erträglich“, erzählt Teamleiter Weisz und ergänzt: „Für die Probanden ist damit keine Aufgabe verbunden. Nur einschlafen sollten sie nicht!“

Wichtig für das Experiment ist, was die Teilnehmer auf die Ohren bekamen: Sequenzen von vier Sinustönen in unterschiedlichen Tonhöhen, dargeboten im Abstand von 333 Millisekunden. Die Tonsequenzen variierten aber je nach Versuchsbedingung. Manchmal waren sie sehr regelmäßig und vorhersagbar, es wiederholten sich die immer gleichen vier Töne; oder aber eine Versuchssequenz startete mit dosiert chaotisierten Tonfolgen, die mal mehr und mal weniger Regelmäßigkeiten zeigten. Die Forscher wollten nun wissen, was im auditorischen Cortex der Probanden in diesen verschiedenen Szenarien passiert. „Selbst wenn ich ganz passiv bin, wird das Gehirn versuchen, Regelmäßigkeiten im Reizstrom zu analysieren“, erklärt der Salzburger Forscher.

Für das Experiment mussten sich die Probanden einen sogenannten Magnetenzephalographie-Helm (MEG-Helm) aufsetzen – also einen Apparat, der die schwachen Magnetfeldänderungen erfasst, die durch die Stromflüsse in verschiedenen Regionen des Gehirns erzeugt werden.

„Ein Vorteil dieser Methode ist die sehr hohe zeitliche Auflösung“, betont Weisz. Man kann also nicht nur feststellen wo, sondern insbesondere wann im Verlauf des Sinuston-Konzerts Signale aus dem auditorischen Cortex aktiv werden – die zeitliche Lokalisation ist die besondere Stärke der Methode, die räumliche Lokalisation eher weniger. Die mittels MEG gemessenen Signale konnten die Neurowissenschaftler dann jedenfalls mit bestimmten Tonhöhen in Verbindung bringen, erklärt Weisz: „Es gibt eine Art Karte der Tonfrequenzen im auditorischen Cortex. Allerdings liegen die jeweils beteiligten Hirnareale für verschiedene Frequenzen so dicht beieinander, dass Sie mit einer konventionellen Analyse wenig Unterschiede sehen.“

Um mit den Daten etwas anfangen zu können, fehlte also noch ein entscheidender Schritt. Man muss den per MEG beobachteten Aktivitätsmustern spezifische Tonhöhen zuordnen. Denn der Sinn des Versuchs ist ja, nicht nur herauszufinden, ob es eine Erwartung des Gehirns bezüglich des Auftretens irgendeines Tons gibt. Die Forscher wollten zeigen, dass diese Erwartung spezifisch für eine bestimmte Frequenz des Tons besteht.

Gängige Statistikmethoden helfen da nicht. Allerdings sind die Aktivitätsmuster in den MEG-Daten ideal für eine Analysemethode, die schon seit einiger Zeit zu einem Lieblingswerkzeug von Wissenschaftlern aller möglichen Fachrichtungen geworden ist: das maschinelle Lernen.

Trainierter Rechenknecht

Wie maschinelles Lernen im Prinzip funktioniert, hat der Münchner „Computerbiologe“ Fabian Theis vor einiger Zeit im Laborjournal-Gespräch (Heft 5/2016) anhand eines anschaulichen Beispiels erklärt: Ein selbst-lernender Algorithmus kann die Fähigkeit erlangen, handschriftlich geschriebene Ziffern zu unterscheiden. Der Algorithmus kann dann beispielsweise eine hingekritzelte „1“ von einer „7“ unterscheiden – weil die Maschine an vielen Beispielen gelernt hat, die typischen Muster zu erkennen, die diese beiden Ziffern unterscheiden.

Ähnlich funktioniert auch der Machine-Learning-Algorithmus, den die Salzburger Forscher auf ihre Daten losließen. Der Rechenknecht lernt in einer Trainingssitzung, welche MEG-Signale eines Probanden mit der Darstellung einer bestimmen Tonfrequenz im auditorischen Cortex zusammenhängen.

Sobald der Algorithmus trainiert ist, kann er die Signale einzelnen Tonhöhen zuordnen: „Wir füttern den Algorithmus mit den Daten unserer 306 Sensoren und befehlen ihm: ‚Differenziere die Signale, die zu den verschiedenen Frequenzen gehören’“, erklärt Weisz. Schon sehr kleine Unterschiede in den Mustern reichen aus, um diese Differenzierungen zu meistern.

Töne vorhergesagt

Das Kernergebnis dieser Versuchsreihen war schließlich: Ungefähr 300 Millisekunden bevor der Ton einer Sequenz dargeboten wird, werden tonhöhenspezifische neuronale Muster stärker aktiviert. Und: Je regelmäßiger die Tonsequenz ist, desto stärker fällt dieses Signal aus. Tatsächlich hat das Gehirn also eine Erwartung bezüglich der Tonhöhe ausgebildet – und mit den Zaubertricks des maschinellen Lernens kann man die damit zusammenhängende neuronale Aktivität aus den MEG-Daten extrahieren.

Wichtig ist Weisz, ein Missverständnis zu vermeiden: Die „Erwartungen“ und „Vorhersagen“ sind keine bewusste Wahrnehmung des Besitzers des Gehirns. „Wenn ich in diesem Kontext von Vorhersagen spreche, dann meine ich einen automatischen Prozess, den das auditorische System erledigt, während Sie sich langweilen.“

Die Arbeit zeigt, dass im Hintergrund ablaufende Erwartungsprozesse eine wichtige Rolle spielen, wenn unser Hirn Tonhöhen auswertet. Mit dem experimentellen Set-up der Salzburger Forscher kann man diese Vorgänge nun nicht-invasiv beim Menschen erforschen, noch dazu mit hoher zeitlicher Auflösung.

Dem Pfeifen auf der Spur

Und was macht man nun mit diesem Wissen? Erst einmal ist es Grundlagenforschung. Die Methode und die Ergebnisse sind ein neuer Zugang zum Verständnis der komplizierten Vorgänge, die im Gehirn ablaufen, wenn sensorischer Input aus der Umwelt auf die Erwartungen und Vorstellungen trifft, die aus dem Gehirn selbst stammen.

Daneben hat die Arbeit aber durchaus auch Bedeutung für ein praktisch-medizinisches Problem, das häufig in den Praxen von Haus- und HNO-Ärzten landet: Tinnitus, das berüchtigte Pfeifen im Ohr.

„Wir sind daran interessiert zu verstehen, wieso eine Person nach einer Hörschädigung Tinnitus entwickelt, eine andere aber nicht. Und wieso der Tinnitus bei manchen Patienten von alleine wieder verschwindet, bei anderen aber nicht. Im Prinzip begreifen wir noch nicht, warum es bei diesem Leiden derart unterschiedliche Verläufe gibt“, erklärt Weisz sein Interesse an den nervigen Tönen. Er und sein Team haben sich schon an die Arbeit gemacht, genauer zu erforschen, welche Rolle die Vorhersagen des Gehirns beim Tinnitus spielt. Die Idee: Eventuell erklären (auch) individuelle Ausprägungen dieser Vorhersagemechanismen, wieso es so große Unterschiede in der Tinnitus-Neigung gibt.

In einer auf einem Preprint-Server erschienenen, noch nicht begutachteten Vorabversion kann man sich schon einmal anschauen, dass sich diese Hypothese zu bestätigen scheint (bioRxiv, doi: 10.1101/869842).

Letzte Änderungen: 06.04.2020