Verlage als Datenkraken

Henrik Müller

(13.05.2022) Während die Schattenbibliothek Sci-Hub das akademische Publikationswesen revolutioniert, stellen kommerzielle Wissenschaftsverlage seit Jahren ihr Geschäftsmodell um: Sie handeln mit Nutzerdaten. Wissenschaftler sind sich dessen selten bewusst. Wer entscheidet in Zukunft über Richtung und Politik öffentlich finanzierter Forschung? Ist die Wissenschaftsfreiheit in Gefahr?

Liegen Manuskripte auf Preprint-Servern und bei Wissenschaftsverlagen in unterschiedlichen Versionen vor, lassen sie sich anhand von Metadaten in ihren PDF-Dateien unterscheiden – also Informationsschnipseln zum Artikeltitel, zu seinen Autoren, zu Erstellungs- und Zugriffszeiten, zum Digital Object Identifier (DOI), zum Dokumentenstatus im Publikationsprozess und zu seiner urheberrechtlichen Lizenzierung. Den Publikationsprozess machen sie transparent und nachvollziehbar.

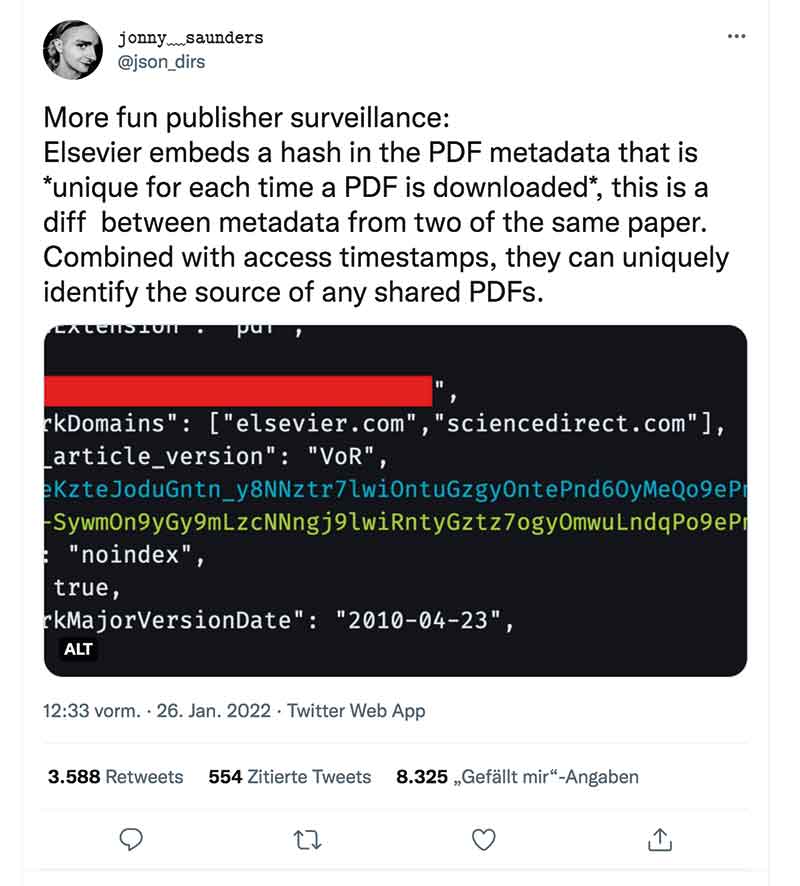

Doch Metadaten eignen sich für mehr. Beispielsweise begann der niederländische Wissenschaftsverlag Elsevier Ende vergangenen Jahres, jede Kopie einer PDF-Datei mit einer einmaligen Zeichenfolge zu versehen. Das Verlagshaus legte diese Praxis nicht offen. Sie fiel einem Twitter-Nutzer auf (siehe Screenshot). Elseviers Erklärung: Mit diesem Fingerprint schütze man Kunden vor Ransomware – also Schadsoftware, mit der IT-Gauner fremde Computer über E‐Mail‐Anhänge, Sicherheitslücken in Webbrowsern oder Cloud-Dienste infizieren und alle Daten des Rechners verschlüsseln, um Lösegeld für die Entschlüsselung zu fordern. Schutz davor bieten nur aktualisierte Betriebssysteme und Antivirusprogramme sowie E-Mail- und Websicherheits-Tools.

Hat ein Verlagshaus ein weiteres Werkzeug der Internetsicherheit erfunden? Laut dem Magazin Vice kann Elsevier nicht erklären, wie es Erpressungs-Software mit PDF-Fingerabdrücken unterbinden will („Academic Journal Claims it Fingerprints PDFs for ‚Ransomware,’ Not Surveillance“, 31.1.2022). Im Übrigen sei dem Datenschutz aber Genüge getan, da keine persönlichen Nutzerdaten gespeichert würden. Das Thema sei keiner weiteren Korrespondenz würdig.

Im Würgegriff der Verlage

Eines ermöglicht der zusätzliche Meta-Tag allerdings: Kombiniert mit dem Zeitstempel eines Downloads kann Elsevier das Nutzerkonto identifizieren, über das die PDF-Datei heruntergeladen wurde. Überwacht der Verlag seine Nutzer? Für eine Antwort ist ein Blick auf seine Geschäftsgebaren notwendig: Ein Oligopol weniger Wissenschaftsverlage kontrolliert einen Weltmarkt von jährlich sechzig Milliarden Euro. Ihr Marktführer Elsevier erwirtschaftete 2019 bei einem Umsatz von drei Milliarden Euro einen Gewinn von einer Milliarde Euro. Drei Geschäftspraktiken machen seit Jahren derartige Umsatzrenditen von dreißig bis vierzig Prozent möglich. Erstens beschäftigen Wissenschaftsverlage Forschungstreibende als Autoren, Gutachter und Herausgeber, bezahlen sie für ihre Tätigkeit aber nicht. Zweitens verlangen sie von Autoren, die Urheberrechte an Artikeln an sie abzutreten. Drittens lassen sie Universitätsbibliotheken die mit Steuergeldern finanzierten Artikel zurückkaufen.

Warum kehren Forscher diesem Hamsterrad nicht den Rücken zu? Felix Schönbrodt, Open-Science-Befürworter und außerplanmäßiger Professor für psychologische Methodenlehre und Diagnostik an der Ludwig-Maximilians-Universität München, fasst das Offensichtliche zusammen: „Weil Wissenschaftler aller Hierarchiestufen das System zu wenig hinterfragen. Sie bemessen ihre wissenschaftliche Karriere an ihrer Publikationsleistung in möglichst angesehenen Journalen. Sich Wissenschaftsverlagen verweigern, heißt für sie, die eigene Zukunft zu trüben.“ Als Resultat erhalten Verlagshäuser laut Bibliotheksstatistik allein von deutschen Standorten jährlich über einhundert Millionen Euro.

Rebellenallianzen

Zumindest bis deutschen akademischen Einrichtungen 2018 nach Jahrzehnten steter Preissteigerungen der sprichwörtliche Kragen platzte. Sie ließen ihre Subskriptionsverträge mit den drei größten Wissenschaftsverlagshäusern Elsevier, Springer Nature und Wiley auslaufen. In den darauffolgenden zwei Jahren verhandelte die Allianz der deutschen Wissenschaftsorganisationen im Rahmen des Projekts DEAL mit Springer Nature und Wiley transformative Open-Access-Verträge aus: In 3.300 Subskriptionszeitschriften beider Verlage können Autoren nun gegen eine Publish-&-Read-(PAR)-Gebühr von 2.750 Euro pro Artikel publizieren. Ihre 550 Golden-Open-Access-Journale verlangen bis zu 4.700 Euro pro Artikel. Mit Elsevier war eine Einigung wegen deren Preisvorstellungen bisher unmöglich.

Da Leser dank DEAL nichts mehr für Wissen zahlen brauchen, hat die Open-Science-Bewegung also einen riesigen Schritt getan? Nicht unbedingt: Laut einer Vergleichsstudie kanadischer Informationswissenschaftler steigen die Publikationskosten durch Transformationsverträge kontinuierlich (Scholars Portal Dataverse, doi: 10.5683/SP2/84PNSG). Denn werden Zeitschriften nicht abonniert, sondern Publikationen pro Stück abgerechnet, lohnt sich der von Jahr zu Jahr steigende Forschungsoutput für Verlage. Open-Science-Advokat Schönbrodt bringt es auf den Punkt: „Publikationsstarke Universitäten werden unter den aktuellen Bedingungen ein riesiges Finanzierungsproblem kriegen. Früher füllte sich die linke Tasche von Verlagen, jetzt schwillt die rechte. Aus wissenschaftsmoralischen Gründen müssen wir vom aktuellen Oligopol der großen kommerziellen Verlage zu wissenschaftsgeleiteten Publikationsstrukturen kommen.“

Extremere Open-Science-Vertreter erschaffen deshalb kostenfreie Volltextdatenbanken – sogenannte Schattenbibliotheken – wie etwa das Projekt Sci-Hub. Es stellte im Januar 2022 mit 85,3 Millionen Publikationen 95 Prozent aller weltweiten Wissenschaftsartikel bereit. Um die Urheberrechtsbestimmungen kommerzieller Verlage schert es sich nicht.

Ein Dorn im Auge des Profits

Seine Popularität bedroht natürlich die Geschäftsmodelle von Wissenschaftsverlagen. Seit 2015 verklagten Elsevier, Springer Nature, Wiley, Cambridge University Press und die American Chemical Society (ACS) deshalb Sci-Hubs Betreiberin, die freiberufliche Web-Programmiererin Alexandra Elbakyan, vor internationalen Gerichten wegen Hackings, Diebstahls und unrechtmäßiger Verbreitung urheberrechtlich geschützten Materials. Meist bekamen sie Recht und Schadenersatz in Höhe mehrerer Millionen Euro zugesprochen. Außerdem ordneten Gerichte an, dass Internetprovider, Webhoster, Domain-Name-Registrare und Suchmaschinen den Zugriff auf Sci-Hub sperren müssen.

Die aus Kasachstan stammende Internetaktivistin stört das wenig. Sie treibt das Katz-und-Maus-Spiel immer neuer Sci-Hub-Internetdomänen weiter (sci-hub-links.com). Warum Sci-Hub dennoch keine Alternative zum wissenschaftlichen Publikationswesen bietet, erörtert Laborjournal in Ausgabe 03/2021 ab Seite 14 (Link).

Die juristischen Möglichkeiten, Schattenbibliotheken aus- und ihre Betreiber einzusperren, sind somit ausgeschöpft. Solange Elbakyan Russland nicht verlässt, haben Verlagshäuser keine Handhabe. Zwar könnten sie Sci-Hub und Co. jegliche Daseinsberechtigung rauben, indem sie auf urheberrechtlich geschützte Zeitschrifteninhalte verzichten. Gleichzeitig müssten dann aber ihre Bezahlschranken fallen. Lieber ändern sie also ihre Strategie im Kampf gegen Schattenbibliotheken.

Zum einen handeln sie DEAL-Verträge aus. Denn wenn sie statt des Lesens das Publizieren besteuern, verlieren Sci-Hub und Co. an Bedeutung. Zum anderen pochen sie auf Internetsicherheit – was den Kreis zu Meta-Tags in PDF-Dateien schließt. Da sich Letztere nämlich ebenfalls in Artikeln von Schattenbibliotheken finden, können Verlage unrechtmäßige Kopien nachvollziehen und diejenigen Nutzerkonten identifizieren, die Sci-Hub und Co. beliefern. Metadaten lassen sich übrigens aus PDF-Dateien auch wieder entfernen – mit ExifTool (exiftool.org), QPDF (qpdf.sourceforge.io), Dangerzone (dangerzone.rocks) und mat2 (0xacab.org/jvoisin/mat2).

Geschäftsmodell: User Tracking

Doch für Wissenschaftsverlage ist das nur der Anfang. Unter dem Namen Scholarly Networks Security Initiative (SNSI) werben Elsevier, Springer Nature, Taylor & Francis, Thieme, Wiley, Wolters Kluwer und andere seit Frühling 2020 dafür, Cyberkriminelle durch sicherheitstechnisch aufgerüstete Bibliotheken bekämpfen zu lassen. Schließlich würden Piraterie-Websites wie Sci-Hub nicht nur Profitmodelle untergraben, sondern stellten ein vom Kreml gesponsertes Sicherheitsrisiko und Hindernis für internationale Forschungseinrichtungen dar. Geht es nach der SNSI, sollen Tracking-Werkzeuge in Bibliothekssoftware in großem Umfang Nutzerdaten erheben: Zugriffszeiten, Verweildauern, Seitenansichten, Geräte- und Account-Informationen, IP-Adressen und Standortdaten.

Besonders wichtig sind Verlagen dabei biometrische Daten. Denn Nutzungsmuster, Tippgeschwindigkeiten und die Art der Mausführung oder Taststeuerung lassen sich zu individuellen Verhaltensdatenprofilen verdichten, anhand derer Einzelpersonen – trotz Proxy-Servern und VPN-Tunneln – identifiziert und von den Verlagshäusern zum „Schutz vor Internet-Piraterie“ kontaktiert werden könnten. Renke Siems, Abteilungsleiter an der Universitätsbibliothek Tübingen, machte in einem Vortrag auf dem Bibliothekartag 2021 klar, dass dies die Sicherheit von Hochschulnetzen gefährden und IT-Angriffe ermöglichen könne („Das Lesen der Anderen: User Tracking auf Verlags-Plattformen“, doi: 10.5446/55619). Auch für Schönbrodt klingt das absurd: „Die SNSI argumentiert mit dem Schutz persönlicher Daten der Forschenden, ihre Spyware greift aber selbst Nutzerdaten in großem Umfang ab.“

Inwieweit arbeiten derartige Tracker auf verlagseigenen Seiten bereits im Hintergrund? Im Juni 2021 warf Laborjournal online einen kurzen Blick auf Elsevier (laborjournal.de/editorials/2262.php) und fand auf Anhieb verschiedene Cookies „to store information regarding mouse position, clicks, scrolls, and highlighted elements and text“ und „to store a unique visitor identifier and organisation identifier […] to track users across domains and services”. Die Stichprobe steht im Einklang mit Langzeitdaten der Münchner Ghostery GmbH (arXiv: 1804.08959): Wer die American Chemical Society, Cambridge University Press, Elsevier, Springer Nature, Taylor & Francis oder Wiley besucht, wird von 31, 39, 36, 55, 28 beziehungsweise 45 Instrumenten nachverfolgt. Zum Vergleich: Facebook, Google, Twitter, Wikipedia und YouTube belästigen nur mit 11, 13, 9, 4 beziehungsweise 14 Trackingtools. Auch Sci-Hubs Informationsbedarf ist geringer: Acht Instrumente kommen dort zum Einsatz.

Verführerische Lebendfalle

Im Gegensatz zu Verlagsseiten setzt die eigene Wissenschaftseinrichtung natürlich keine Überwachungswerkzeuge ein – es sei denn, Verlage locken mit monetären Vergünstigungen. Im Mai 2020 unterzeichneten die Vereinigungen aller niederländischen Universitäten und Universitätskliniken einen Fünf-Jahres-Vertrag mit Elsevier. Dank ihm können niederländische Wissenschaftler ohne zusätzliche Kosten im Open Access publizieren, wenn die Universitäten im Gegenzug die Forschungsinformationssysteme von Elsevier einsetzen und sich zur Kooperation in „Metadaten-Projekten“ bereit erklären. Was mit den Metadaten geschieht, spezifiziert das Vertragswerk nicht. Im Interview mit der wissenschaftspolitischen Zeitschrift Forschung & Lehre bezeichnet Petra Gehring, die Vorsitzende des deutschen Rates für Informationsinfrastrukturen, das im August 2021 als „Lebendfalle für Forschende“: „Große Player betrachten den gesamten intellektuellen Zyklus staatlich getragener und damit freier Forschung als ihr künftiges Produkt“ („‚Das Schicksal von Open Science steht auf dem Spiel’”, 2.8.2021).

Tracking von Wissenschaftlern ist also kein Zukunftsthema mehr, sondern Teil einer größeren Geschäftsstrategie, wie Renke Siems in seinem Artikel „Das Lesen der Anderen“ erklärt (o-bib; doi: 10.5282/o-bib/5797). Bepreisen Verlage anstelle des Lesens das Publizieren, sichern sie trotz Sci-Hub nicht nur ihre Erlöse, sondern können Dokumente verlagsübergreifend auswerten und Nutzerverhalten nachzeichnen.

Tatsächlich ist Tracking in der Wissenschaft bereits so verbreitet, dass die Deutsche Forschungsgemeinschaft (DFG) im Mai 2021 ein warnendes Informationspapier herausgab (doi: 10.5281/zenodo.5900759). Sie sieht nicht nur Persönlichkeits- und Wettbewerbsrechte, sondern auch die Freiheit von Lehre und Forschung bedroht. Elsevier widersprach am 18.6.2021 auf seiner Website: Die DFG-Stellungnahme enthalte nur Mutmaßungen und falsche Beschuldigungen („Elsevier-Antwort auf DFG-Papier Datenverfolgung in der Forschung“). Zum einen genieße die Privatsphäre von Nutzern höchste Priorität bei Wissenschaftsverlagen, zum anderen würden sie Nutzungsdaten nicht an Dritte verkaufen.

Elsevier ist Teil des Medienkonzerns RELX, der laut einem Bericht des US-Committee on Commerce, Science and Tranportation unter dem Namen Reed Elsevier über Jahre die Nutzerdaten von Millionen Kunden verkaufte („Review of the Data Broker Industry: Collection, Use, and Sale of Consumer Data for Marketing Purposes 2013“). Im Jahr 2018 erwarb RELX‘ Tochterunternehmen LexisNexis die digitale Identitätsplattform ThreatMetrix, die laut eigenen Angaben über die Adressdaten und Geräteinformationen mehrerer Milliarden Personen verfügt . ThreatMetrix‘ Tracking-Werkzeuge sind Elseviers Cookie-Richtlinien zufolge auf dessen Internetplattform implementiert. Vergangenes Jahr veräußerte LexisNexis laut der Whistleblower-Plattform „The Intercept“ Nutzerdaten für 16,8 Millionen US-Dollar an die US-Immigrationsbehörde. RELX investiert außerdem in Palantir, einem US-Anbieter zur Analyse großer Datenmengen und Dienstleister für Bundesbehörden und Nachrichtendienste.

Vom Verlag zum Datenmoloch

Sind Tracking-Werkzeuge zur Bekämpfung von Schattenbibliotheken also nur ein Vorwand? Elseviers Internetpräsenz belegt: Nicht länger sieht sich das Medienunternehmen als Verlagshaus, sondern laut eigener Website als „global leader in information and analytics“. Diesen Anspruch untermauerte Elsevier im vergangenen Jahrzehnt durch den Aufkauf verschiedener Datenanalyseprodukte: des Forschungsinformationssystems Pure (2012), des Referenz- und Kontaktemanagers Mendeley (2013), der Analysesoftware zur Medienüberwachung Newsflo (2015), des elektronischen Laborjournals Hivebench (2016), des Preprint-Servers SSRN (2016), des Open-Access-Repository Bepress (2017) und des Bibliometrie-Service Plum X (2017).

In 2016 rief Elsevier außerdem Mendeley Data, eine Plattform zum Online-Sharing von Forschungsdaten, und den Online-Stellenmarkt Mendeley Careers ins Leben. Zusammen mit seiner interaktiven Lehrsoftware für Studenten Sherpath, Verlagsdatenbank ScienceDirect, Recherche- und Zitationsdatenbank Scopus und Benchmarking-Software für wissenschaftliche Produktivität SciVal bietet das ehemalige Verlagshaus damit ein Betriebssystem hoch-integrierter Dienste für den gesamten Forschungsprozess an – von der Ausbildung von Studenten bis zur Performance-Analyse ganzer Forschungseinrichtungen. Laut Siems‘ Vortrag auf dem Bibliothekartag 2021 bauen die Verlage „zusammenhängende Biotope“ auf, die Forscher nicht mehr verlassen müssen – und auch nicht sollen.

Auch Elseviers Konkurrenten wie etwa Springer Natures Verlagsgruppe Georg von Holtzbrinck oder das Analytikunternehmen Clarivate profilieren sich seit Jahren als Alleinanbieter proprietärer Produkte für alle Abschnitte des Wissenschaftsprozesses. Clarivate gibt Wissenschaftlern beispielsweise so verführerische Werkzeuge wie die Bibliografie-Software EndNote, das Peer-Review-Management-System ScholarOne und den Publikations-Tracker Publons an die Hand. Anhand der Daten seines Zitierungsnetzwerks Web of Science bestimmt Clarivate mit dem Impact-Faktor sogar über die zentrale Größe des Wissenschaftsbetriebs.

Kurzum: Niemand in der Wissenschaftsgemeinde kann Datenhandelsplattformen mehr entkommen. Elsevier und Co. haben die Umsatzrenditen ihrer Verlagsgeschäfte genutzt, um ihr Oligopol im Zugriff auf wissenschaftliche Information auf den gesamten Lebenszyklus öffentlich finanzierter Forschung auszubauen. Selbst wer Großverlage boykottiert, wird früher oder später von irgendeinem Tracking-Werkzeug erfasst. Schleichend und kontinuierlich machen die ehemaligen Verlagshäuser ihre Online-Werkzeuge unverzichtbar für die Steuerung von Wissenschaftseinrichtungen.

Überwachungskapitalismus

Das ist keine Zufallsentwicklung. Monopolistische Privatunternehmen wie Elsevier wollen wissen, wer, wo, wie viel, mit wem und worüber forscht und welche gesellschaftlichen Trends das auslöst. Denn Letztere frühzeitig zu erkennen, ist bare Münze wert. Längst ist der Handel mit Wissen über Forschungsinhalte und ihre Akteure relevanter Aspekt von Elseviers „Verlagstätigkeit“ geworden. Laut Jahresbericht 2021 erwirtschafteten seine Datenbanken und IT-Werkzeuge über 35 Prozent der 3,2 Milliarden Euro Einkommen. Das Gleiche gilt für Elseviers Mutterkonzern RELX. Bestimmten im Jahr 2000 noch Printprodukte 64 Prozent von RELX‘ Einkommen, machen sie zwanzig Jahr später noch acht Prozent aus. Im Jahr 2021 erwirtschaftete RELX 86 Prozent seines Gesamteinkommens von 8,6 Milliarden Euro mit „elektronischen Produkten“. Sein jüngster Jahresbericht fasst zusammen: „We look at the continued migration of the business towards electronic delivery, the increasing introduction of electronic decision tools, group level financial metrics, and corporate responsibility and sustainability metrics“.

Und die Betroffenen? Forscher scheint es wenig zu stören, dass eine privatisierte Wissensindustrie im Gegensatz zur Wissenschaftsfreiheit steht. So verzeichnet beispielsweise die Initiative „Stop tracking Science“ gegenwärtig 1.300 Unterzeichner – bei 480.000 deutschen Wissenschaftlern. „Dabei bräuchte sich die Wissenschaftsgemeinde die Publikationsregeln nicht von Verlagen diktieren lassen“, kommentiert Open-Science-Advokat Schönbrodt. „Ohne unsere Forschungsdaten, unsere Arbeitsleistung und unser stillschweigendes Einverständnis wären kommerzielle Akteure machtlos.“ Während Forscher das Hamsterrad des wissenschaftlichen Publikations- und Reputationssystems weiter in Schwung halten, agieren ehemalige Verlagshäuser schon mal als Auftragnehmer des Open Science Monitors der Europäischen Kommission. Dort überwachen sie den Übergang zum Open Access – also dem Zugriff auf Wissen ohne kommerzielle Interessen.