Bisweilen zieht sich eine gewisse kollegiale Schlampigkeit durch die Forscherzunft. Zum Beispiel, wenn es darum geht, Kolleginnen und Kollegen auf Anfrage weitere Informationen zu den eigenen publizierten Studien mitzuteilen. Dazu berichten wir beispielsweise Folgendes unter „Inkubiert“ in unserem aktuellen Heft:

Bisweilen zieht sich eine gewisse kollegiale Schlampigkeit durch die Forscherzunft. Zum Beispiel, wenn es darum geht, Kolleginnen und Kollegen auf Anfrage weitere Informationen zu den eigenen publizierten Studien mitzuteilen. Dazu berichten wir beispielsweise Folgendes unter „Inkubiert“ in unserem aktuellen Heft:

Dass gerade Letzteres es häufig nahezu unmöglich macht, publizierte Ergebnisse durch „Nachkochen“ zu bestätigen, illustriert eine frische Arbeit zur Replizierbarkeit von Studien aus der präklinischen Krebsforschung (eLife 10: e67995). Insgesamt wollten deren Autoren 193 Experimente aus 53 Arbeiten replizieren. Jedoch fehlten darin zu viele wichtige Informationen über Methodik und Ergebnisse – oder waren zumindest ungenügend. Am Ende konnten sie für kein einziges Experiment ein Protokoll zu dessen Wiederholung entwerfen, ohne die Originalautoren um klärende Details zu bitten. Allerdings antwortete jeder Dritte von ihnen daraufhin überhaupt nicht, und nur ein Viertel lieferte wirklich hilfreiche Unterstützung.

Und siehe da, gerade eben sind wir über eine weitere Studie gestolpert, die ganz frisch über ähnlich schwaches Verhalten hinsichtlich Data Sharing berichtet. Ihr Titel lautet „Frequency of receiving requested data for a systematic review and associated factors: A cross-sectional study“, verfasst hat sie ein brasilianisches Autorenteam (Account. Res. 29(3): 165-77). Sinngemäß übersetzt steht als Kernergebnis im Abstract:

Ziel dieser Studie war es abzuschätzen, wie häufig man Daten erhält, die für das Verfassen eines systematischen Reviews angefordert wurden. Dazu kontaktierten wir per E-Mail Autoren von Studien mit dem Anliegen, dass wir zusätzliche Daten von ihnen benötigten. […] Von den 164 angeschriebenen Studien antworteten 110 (67,1 %), 51 schickten angeforderte Daten (31,1 %). Die mittlere Zeit bis zum Erhalt einer Antwort […] betrug 36 Tage. […] Das Anfordern von Daten für einen systematischen Review kostete folglich viel Zeit und hatte überhaupt nur bei drei von zehn Studien Erfolg.

Könnte es sein, dass die ach so gerne beschworene Scientific Community in punkto kollegiales Verhalten doch deutlich mehr Luft nach oben hat, als viele von ihrer eigenen Zunft gerne wahrhaben wollen? Und dass man vom hehren Ideal des freien Datenaustauschs zugunsten einer Open Science weiter entfernt ist, als man dachte? Schließlich scheint dieser ja noch nicht einmal auf direkte Nachfrage gut zu klappen.

Ralf Neumann

(Illustr.: pngtree)

So begannen wir unseren Artikel

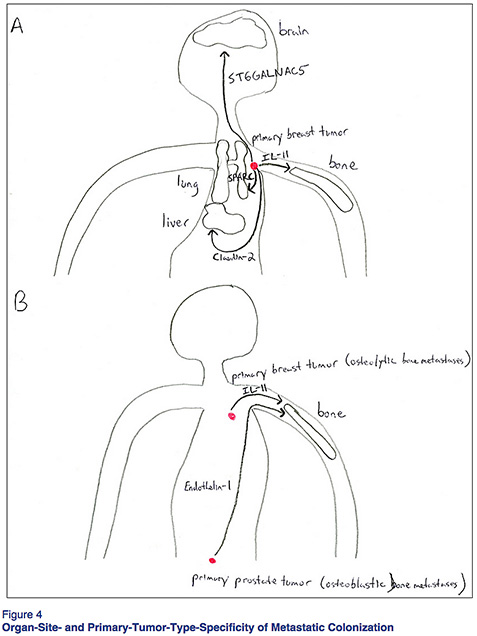

So begannen wir unseren Artikel  Reviews sind wichtig, keine Frage. Oftmals macht der breite Blick auf’s Feld erst richtig klar, wo es wirklich steht — und viel wichtiger: welches die drängendsten offenen Fragen sind.

Reviews sind wichtig, keine Frage. Oftmals macht der breite Blick auf’s Feld erst richtig klar, wo es wirklich steht — und viel wichtiger: welches die drängendsten offenen Fragen sind.

Aus der Reihe „Spontane Interviews, die es nie gab — die aber genau so hätten stattfinden können”. Heute: Prof. E. Isern, Striktologisches Institut Universität Hochlattburg.

Aus der Reihe „Spontane Interviews, die es nie gab — die aber genau so hätten stattfinden können”. Heute: Prof. E. Isern, Striktologisches Institut Universität Hochlattburg.

Schon mal zitiert worden, bevor das Paper überhaupt offiziell veröffentlicht war?

Schon mal zitiert worden, bevor das Paper überhaupt offiziell veröffentlicht war?