Haben Sie auch noch jede Menge Daten in der sprichwörtlichen Schublade liegen? Daten, die schon lange eine nette, kleine „Story“ ergeben würden — wenn man sie nur mal in Manuskriptform bringen würde?

Wie bitte, in Ihrer Schublade schlummert Stoff für mehrere solcher kleinen, aber feinen Manuskripte? Oder in ihrem Regal?…

Keine Angst, Sie sind nicht allein.

Schon vor einiger Zeit stellte eine englische Forscherin den Kollegen in ihrem (leider nicht mehr existenten) Blog im Prinzip dieselbe Frage: „Stellt Euch vor, ihr bekommt keine Fördergelder mehr und könnt Euch einzig darauf konzentrieren, alle vorhandenen Daten zusammenzuschreiben — für wie lange hättet Ihr noch „Stoff“?“ Und sie meinte damit nicht das Umschreiben bereits eingereichter Manuskripte; es ging ihr vielmehr um die vielen, praktisch publikationssreif abgeschlossenen (Seiten-)Projekte, die bislang dennoch nie wirklich oben auf dem Schreibtisch gelandet waren.

Heraus kam, dass dieses Phänomen den meisten Forschern, die schon länger im Geschäft sind, offenbar wohlbekannt ist: Die Mehrzahl der Antworten lag zwischen drei und fünf Jahren.

Drei bis fünf Jahre lang könnte der Durchschnitts-Seniorforscher also noch Manuskripte schreiben — allein mit den Daten, die er längst schon hat. Da er diese Zeit aber beileibe nicht nur mit Paperschreiben verbringen kann, werden wohl jede Menge dieser interessanten kleinen (und hin und wieder vielleicht sogar großen) Geschichten niemals veröffentlicht. „Survival of the fittest results“ nennt die Autorin das treffend.

Woher aber kommt der entsprechende Selektionsdruck? Wohl daher, dass das Publikations-dominierte Belohnungssystem dem Forscher die folgende Zwickmühle beschert hat: Will er seinen Job gut machen, sollte er stets seine Resultate sorgfältig prüfen, hart nach alternativen Erklärungen fahnden und sie immer mit der aktuellen Literatur abgleichen. Das allerdings kostet Zeit. Wenn Forscher X aber zu viel Zeit mit diesen Dingen „vertrödelt“, riskiert er, als unproduktiv abgestempelt zu werden. Und dann kann es schnell schwer werden, weiterhin Fördergelder zu bekommen.

Also bunkert Forscher X das weniger dringende Material in der Schublade und schreibt lieber erstmal den nächsten Antrag — nicht zuletzt auch, um das Hauptprojekt der Gruppe weiter am Laufen zu halten. Wird dieser dann bewilligt, muss er natürlich umgehend die beantragten Projekte auch machen. Mit den resultierenden Daten muss er gleich wieder Paper schreiben, damit er frische Argumente für den nächsten Folgeantrag hat… — und so geht das Spiel in die nächste Runde

Und während diese Mühle unerbittlich weiter läuft, versinkt das, was er in der Schublade bunkert, tiefer und tiefer im Staub.

Wer weiß, wie viele kleine Schätze mit etwas weniger Antragsdruck von dort geborgen werden könnten..

Ralf Neumann

Foto: iStock / Paperkites

x

Mitarbeiter der Annals of Internal Medicine stellten vorletzte Woche auf dem

Mitarbeiter der Annals of Internal Medicine stellten vorletzte Woche auf dem  Und wieder ein Zitat aus einer E-Mail an unsere Redaktion. Ein Bio-Emeritus im aktiven Unruhestand prangert darin mit deutlichen Worten einige „Unsitten“ im aktuellen Forschungsbetrieb an:

Und wieder ein Zitat aus einer E-Mail an unsere Redaktion. Ein Bio-Emeritus im aktiven Unruhestand prangert darin mit deutlichen Worten einige „Unsitten“ im aktuellen Forschungsbetrieb an: Reviews sind wichtig, keine Frage. Oftmals macht der breite Blick auf’s Feld erst richtig klar, wo es wirklich steht — und viel wichtiger: welches die drängendsten offenen Fragen sind.

Reviews sind wichtig, keine Frage. Oftmals macht der breite Blick auf’s Feld erst richtig klar, wo es wirklich steht — und viel wichtiger: welches die drängendsten offenen Fragen sind.

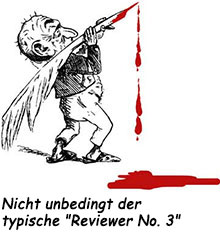

Als er sich schließlich halbwegs von dem Schock erholt hatte, stieg Zorn in ihm hoch — und er begann, sich „das Arschloch“ vorzustellen. „Sicher so ein frustrierter alter Sack, kurz vor der Pensionierung“, dachte X. „Ein ergrautes, faltiges Alphatier, das Spaß daran hat, den Jungen nochmal so richtig zu zeigen, wo der Hammer hängt. Der ansonsten aber gerade darüber verbittert, dass seine Zeit nun endgültig bald vorbei ist. Da kommt ihm ein Manuskript von so einem kleinen Würstchen wie mir natürlich gerade recht, um all den Frust und die Verbitterung unerkannt, aber wirksam rauszulassen.“

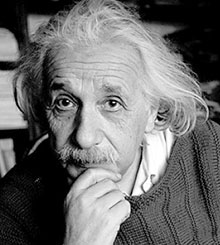

Als er sich schließlich halbwegs von dem Schock erholt hatte, stieg Zorn in ihm hoch — und er begann, sich „das Arschloch“ vorzustellen. „Sicher so ein frustrierter alter Sack, kurz vor der Pensionierung“, dachte X. „Ein ergrautes, faltiges Alphatier, das Spaß daran hat, den Jungen nochmal so richtig zu zeigen, wo der Hammer hängt. Der ansonsten aber gerade darüber verbittert, dass seine Zeit nun endgültig bald vorbei ist. Da kommt ihm ein Manuskript von so einem kleinen Würstchen wie mir natürlich gerade recht, um all den Frust und die Verbitterung unerkannt, aber wirksam rauszulassen.“ Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden.

Auch Einstein hielt anfangs nicht viel von Peer Review. Aus seiner „deutschen Zeit“ kannte er dieses System, etwa von seinen fünf berühmten 1905er-Artikeln in den Annalen der Physik, überhaupt nicht. Erst nachdem er in die USA ausgewandert war, sah er sich plötzlich damit konfrontiert, dass seine Manuskripte bisweilen zunächst irgendwelchen Kollegen zur Begutachtung vorgelegt wurden. Forscher Müller hat eine Kooperation mit Meier. Eines Tages erhält Müller überraschend ein Manuskript von Meier. Er finde, dass die gemeinsamen Daten inzwischen für eine „nette, kleine Publikation“ reichen, schreibt Meier dazu. Müller findet das nicht. Er schreibt zurück, dass er lieber noch die ein oder andere Testreihe durchziehen wolle, um der „Story“ mehr Substanz zu verleihen. Meier entgegnet, dass dies seiner Meinung nach unnötig sei — die Geschichte wäre auch so schon klar. Und überhaupt habe dessen Gruppe ja nur etwa zwanzig Prozent zum aktuellen Manuskript beigetragen. Wenn er die jetzt wieder rausnehme und ein paar kleine Experimente selber mache, könne er das Paper auch gut ohne ihn veröffentlichen. „Tu, was Du nicht lassen kannst“, schreibt Müller sinngemäß zurück — und schmeißt das Manuskript in den Müll.

Forscher Müller hat eine Kooperation mit Meier. Eines Tages erhält Müller überraschend ein Manuskript von Meier. Er finde, dass die gemeinsamen Daten inzwischen für eine „nette, kleine Publikation“ reichen, schreibt Meier dazu. Müller findet das nicht. Er schreibt zurück, dass er lieber noch die ein oder andere Testreihe durchziehen wolle, um der „Story“ mehr Substanz zu verleihen. Meier entgegnet, dass dies seiner Meinung nach unnötig sei — die Geschichte wäre auch so schon klar. Und überhaupt habe dessen Gruppe ja nur etwa zwanzig Prozent zum aktuellen Manuskript beigetragen. Wenn er die jetzt wieder rausnehme und ein paar kleine Experimente selber mache, könne er das Paper auch gut ohne ihn veröffentlichen. „Tu, was Du nicht lassen kannst“, schreibt Müller sinngemäß zurück — und schmeißt das Manuskript in den Müll. Gerade am Telefon folgende interessante Geschichte gehört:

Gerade am Telefon folgende interessante Geschichte gehört: Kurz nach Neujahr veröffentlichte

Kurz nach Neujahr veröffentlichte