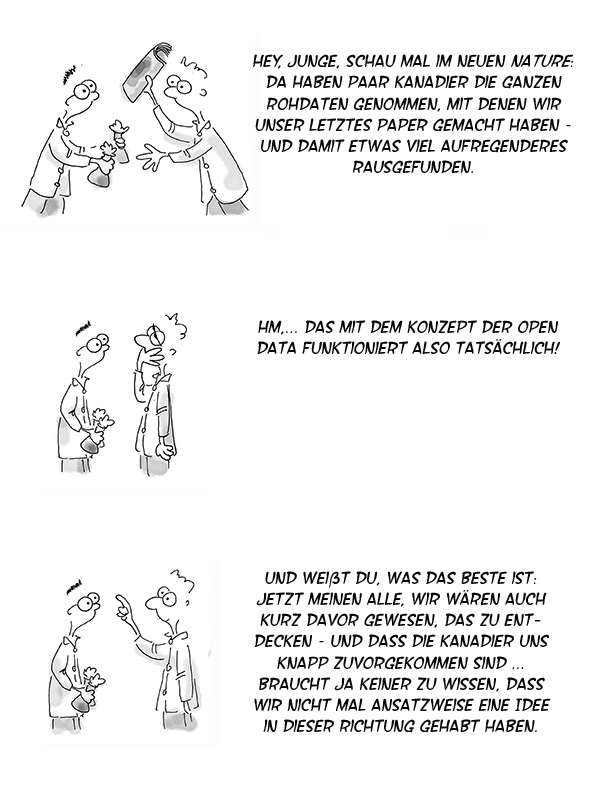

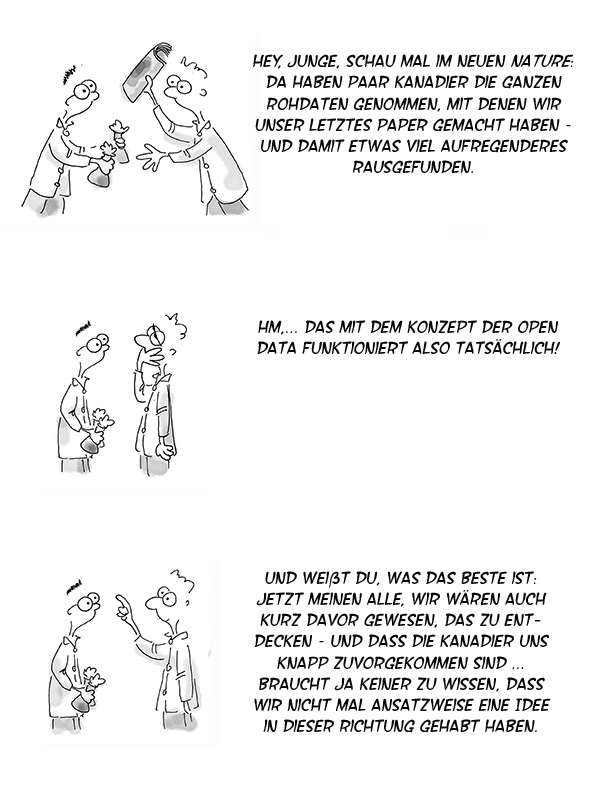

Unser Forscher Ernst lernt die Vorzüge des Offenlegens aller Forschungsdaten kennen …

(Gezeichnet von Rafael Florés. Jede Menge weiterer Labor-Abenteuer von „Forscher Ernst“ gibt es hier.)

Unser Forscher Ernst lernt die Vorzüge des Offenlegens aller Forschungsdaten kennen …

(Gezeichnet von Rafael Florés. Jede Menge weiterer Labor-Abenteuer von „Forscher Ernst“ gibt es hier.)

Bisweilen zieht sich eine gewisse kollegiale Schlampigkeit durch die Forscherzunft. Zum Beispiel, wenn es darum geht, Kolleginnen und Kollegen auf Anfrage weitere Informationen zu den eigenen publizierten Studien mitzuteilen. Dazu berichten wir beispielsweise Folgendes unter „Inkubiert“ in unserem aktuellen Heft:

Bisweilen zieht sich eine gewisse kollegiale Schlampigkeit durch die Forscherzunft. Zum Beispiel, wenn es darum geht, Kolleginnen und Kollegen auf Anfrage weitere Informationen zu den eigenen publizierten Studien mitzuteilen. Dazu berichten wir beispielsweise Folgendes unter „Inkubiert“ in unserem aktuellen Heft:

Dass gerade Letzteres es häufig nahezu unmöglich macht, publizierte Ergebnisse durch „Nachkochen“ zu bestätigen, illustriert eine frische Arbeit zur Replizierbarkeit von Studien aus der präklinischen Krebsforschung (eLife 10: e67995). Insgesamt wollten deren Autoren 193 Experimente aus 53 Arbeiten replizieren. Jedoch fehlten darin zu viele wichtige Informationen über Methodik und Ergebnisse – oder waren zumindest ungenügend. Am Ende konnten sie für kein einziges Experiment ein Protokoll zu dessen Wiederholung entwerfen, ohne die Originalautoren um klärende Details zu bitten. Allerdings antwortete jeder Dritte von ihnen daraufhin überhaupt nicht, und nur ein Viertel lieferte wirklich hilfreiche Unterstützung.

Und siehe da, gerade eben sind wir über eine weitere Studie gestolpert, die ganz frisch über ähnlich schwaches Verhalten hinsichtlich Data Sharing berichtet. Ihr Titel lautet „Frequency of receiving requested data for a systematic review and associated factors: A cross-sectional study“, verfasst hat sie ein brasilianisches Autorenteam (Account. Res. 29(3): 165-77). Sinngemäß übersetzt steht als Kernergebnis im Abstract:

Ziel dieser Studie war es abzuschätzen, wie häufig man Daten erhält, die für das Verfassen eines systematischen Reviews angefordert wurden. Dazu kontaktierten wir per E-Mail Autoren von Studien mit dem Anliegen, dass wir zusätzliche Daten von ihnen benötigten. […] Von den 164 angeschriebenen Studien antworteten 110 (67,1 %), 51 schickten angeforderte Daten (31,1 %). Die mittlere Zeit bis zum Erhalt einer Antwort […] betrug 36 Tage. […] Das Anfordern von Daten für einen systematischen Review kostete folglich viel Zeit und hatte überhaupt nur bei drei von zehn Studien Erfolg.

Könnte es sein, dass die ach so gerne beschworene Scientific Community in punkto kollegiales Verhalten doch deutlich mehr Luft nach oben hat, als viele von ihrer eigenen Zunft gerne wahrhaben wollen? Und dass man vom hehren Ideal des freien Datenaustauschs zugunsten einer Open Science weiter entfernt ist, als man dachte? Schließlich scheint dieser ja noch nicht einmal auf direkte Nachfrage gut zu klappen.

Ralf Neumann

(Illustr.: pngtree)

Für unser kommendes April-Heft haben wir mehrere Protagonisten der virologischen und epidemiologischen Forschung gefragt, wie sie nach über einem Jahr die hiesige Corona-Forschung beurteilen würden. Unabhängig voneinander nannten sie die systematische Erhebung, Zusammenführung und Auswertung ausreichender Datenmengen als eklatantestes Problem. Das hätte nach deren Meinung gleich in verschiedenen Zusammenhängen deutlich besser laufen können. So heißt es etwa in dem Gespräch mit dem Essener Virologen Ulf Dittmer:

Ein schlechtes Zeugnis stellt Dittmer hingegen der klinischen Forschung zu COVID-19 hierzulande aus. „Klinische Studien zu antiviralen Therapieoptionen zum Beispiel – diese Daten kommen ja fast alle aus England oder den USA.“ Den Grund dafür sieht er in den universitären Strukturen und der Eigenständigkeit der Universitätskliniken. „Als erstes kommt der Konkurrenzgedanke auf“, bedauert er. Das Interesse an gemeinsamen Studien sei gering, sobald die eine Uniklinik eigene Daten einem anderen Partner überlassen müsse. „Das staatlich organisierte System in England hat sicherlich viele Nachteile für das Gesundheitswesen“, räumt Dittmer ein, „aber gerade klinische Multi-Center-Studien funktionieren dort sehr gut; es gehören ja alle Krankenhäuser zusammen, und die tauschen dann auch Daten miteinander aus.“

Der Düsseldorfer Virologe Jörg Timm dagegen vermisst bis heute umfassende Untersuchungen zum Infektionsgeschehen an Schulen:

… Derzeit kooperiert sein Team mit der Universität Bochum, um Infektionsausbrüche an Schulen genauer zu erforschen. „Wir haben schon vermutete Übertragungen innerhalb von Schulen gehabt, die wir über die Sequenzierung bestätigen konnten“, berichtet er. „Aber ebenso gab es vermutete Ausbrüche, bei denen wir über die Sequenzierung zeigen konnten, dass unterschiedliche Einträge von außen dahinter steckten“. Eigentlich seien das recht einfache Untersuchungen, sagt Timm – und hofft, auf diesem Wege in den kommenden Monaten fundierte Ergebnisse zu bekommen, um auf deren Basis über Schulschließungen oder Klassenteilungen in den Altersgruppen zu entscheiden. „Da fehlt es in der Tat noch gewaltig an Daten.“

Und er ergänzt an anderer Stelle:

Um volle Fahrt aufzunehmen, scheiterte es bisher an der Finanzierung. „Wir hätten das gern größer aufgesetzt, doch letztlich stand uns nur das Budget für Forschung und Lehre zur Verfügung“, bedauert Timm.

Der Gießener Virologe Friedemann Weber hingegen kritisierte vor allem, dass Deutschland in der SARS-CoV-2-Vollsequenzierung aus Patientenproben international weit hinterherhinkt:

Allerdings bestätigt auch Weber den Eindruck, dass die Surveillance durch Vollsequenzierung in Deutschland ausbaufähig ist. „Ich glaube, da hat Deutschland einfach keine solche Tradition. Die Briten haben diese Strukturen ja eng an den National Health Service gekoppelt, und das ist eine große Stärke.“ Schließlich müssten die Sequenzen ja auch irgendwo zusammenlaufen und bewertet werten. „Deutschland ist bei der Public Health generell nicht so stark aufgestellt“, findet Weber.

Der Wiener Physiker und Modellierer Peter Klimek machte für Österreich ähnliche Probleme aus, illustrierte sie jedoch mit seinen Studien zur Wirksamkeit nicht-pharmakologischer Maßnahmen:

Zusammen mit Kollegen aus Frankreich und den USA analysierte sein Team Daten aus 56 Staaten, um die Wirksamkeit nicht-pharmakologischer Maßnahmen zu ranken (Nat. Hum. Behav. 4(12): 1303-12). Für Österreich war es jedoch schwer, an verwertbare Daten zu kommen. „Wir haben das Problem, dass unser Gesundheitssystem sehr fragmentiert ist“, ordnet Klimek die Schwierigkeiten beim Zusammentragen und Auswerten ein. „Im Prinzip sind viele Daten vorhanden, aber sie werden nirgends zusammengeführt.“

Und Dittmer machte dieses Problem der mangelnden Datenzusammenführung vor allem auch für Deutschlands Gesundheitsämter aus:

Aber hätten wir nicht seit dem März ausreichend und systematisch Daten sammeln können, um sehr gezielt und evidenzbasiert auf wirksame Maßnahmen im Herbst zu setzen? Und wären diese damit nicht auch politisch besser kommunizierbar gewesen? „Ich glaube, da hatten wir ein eklatantes Problem“, stimmt Dittmer zu. „Es ist uns nicht gelungen, Daten aus den Gesundheitsämtern, die eigentlich vorhanden waren, wissenschaftlich auszuwerten und in Handlungsanweisungen umzumünzen.“ Die Gesundheitsämter seien im Frühjahr völlig überlastet gewesen. […] Offenbar sind also durchaus Daten vorhanden, aber sie konnten nicht aufbereitet werden. „Bei allen Meldungen, die dann im RKI ankamen, kannte man deshalb auch nur von einem Fünftel der Infektionen deren Ursprung. Wenn jedes Gesundheitsamt einen Wissenschaftler im Haus hätte, der nichts anderes macht, als Daten zusammenzutragen und auszuwerten, wären wir deutlich weiter.“

Der Eindruck verdichtet sich also, dass die hiesige Corona-Forschung bislang tatsächlich unter einem deutlichen „Datenproblem“ litt.

(Die vollständigen Gespräche mit den genannten und weiteren Forschern gibt’s dann ab 8. April in unserem neuen Heft.)

Mario Rembold

(Foto: AdobeStock / NicoElNino)

Bescheidenheit ist eine Zier, hieß es früher einmal. In der Forschung jedoch scheint das immer weniger zu gelten. Da hat vielmehr die Unsitte des „Überverkaufens“ von Ergebnissen zuletzt immer stärker zugenommen.

Angesichts des stetig zunehmenden Publikations- und Karrieredrucks ist dies allerdings auch kein Wunder. Vom Ende seines Zeitvertrags oder Ähnlichem bedroht, bläst der eine oder die andere ein Fiat-Uno-Resultat im Paper-Manuskript gern zu einem Porsche auf. So manche Pressestelle verstärkt es umgehend nochmals – und in den sozialen Medien gerät es dann sowieso außer Kontrolle.

Dennoch ist solches „Überverkaufen“ von Forschungsergebnissen kein wirklich neues Phänomen. Wobei es bisher vielleicht noch eindrücklicher beim Beschreiben von Forschungsvorhaben auftrat. Denn zumindest beim Gerangel um Forschungsgelder wimmelt es schon seit Jahrzehnten in den Anträgen sinngemäß von deutlich übertriebenen Versprechungen wie: „Letztendlich könnten die Ergebnisse des Projekts in ein völlig neues Therapiekonzept für Krebs münden.“ Oder den Anbau und Ertrag aller möglichen Nutzpflanzen revolutionieren. Oder das Geheimnis lüften, wie in unseren Gehirnen Bewusstsein entsteht. Oder ähnliches überzogenes Antrags-Geklapper.

In diesem Zusammenhang hatte der Ökotoxikologe John Sumpter von der Londoner Brunel University zuletzt eine interessante Idee geäußert. In einem Essay in Times Higher Education schlägt er vor, in wissenschaftlichen Artikeln den Abschnitt „Conclusions“ durch „Limitations“ zu ersetzen. In den „Conclusions“ würde ohnehin nur wiederholt, was schon weiter vorne steht, so Sumpter. Müssten die Autoren dagegen gezielt formulieren, wo die Grenzen für die Interpretation ihrer Ergebnisse liegen, erhielte man am Ende womöglich deutlich robustere Paper.

Auf jeden Fall hätten auf diese Weise wohl arg überzogene Schlussfolgerungen wie die folgende ein Ende: „Weitere Forschung in dieser Richtung könnte es nun ermöglichen, die Ausprägung des Darm-Mikrobioms durch gezielte Interventionen so zu steuern, dass die kognitive Entwicklung von Kleinkindern unterstützt wird.“ (Biol. Psychiat. 83(2), 148-59) Argh! Nicht zu Unrecht zeichnete der US-Mikrobiologe Jonathan Eisen dieses Paper in seinem Blog Phylogenomics mit dem „Overselling the Microbiome Award“ aus.

Ralf Neumann

(Illustr.: R@TTENcomiCS)

Haben Sie auch noch jede Menge Daten in der sprichwörtlichen Schublade liegen? Daten, die schon lange eine nette, kleine „Story“ ergeben würden — wenn man sie nur mal in Manuskriptform bringen würde?

Wie bitte, in Ihrer Schublade schlummert Stoff für mehrere solcher kleinen, aber feinen Manuskripte? Oder in ihrem Regal?…

Keine Angst, Sie sind nicht allein.

Schon vor einiger Zeit stellte eine englische Forscherin den Kollegen in ihrem (leider nicht mehr existenten) Blog im Prinzip dieselbe Frage: „Stellt Euch vor, ihr bekommt keine Fördergelder mehr und könnt Euch einzig darauf konzentrieren, alle vorhandenen Daten zusammenzuschreiben — für wie lange hättet Ihr noch „Stoff“?“ Und sie meinte damit nicht das Umschreiben bereits eingereichter Manuskripte; es ging ihr vielmehr um die vielen, praktisch publikationssreif abgeschlossenen (Seiten-)Projekte, die bislang dennoch nie wirklich oben auf dem Schreibtisch gelandet waren.

Heraus kam, dass dieses Phänomen den meisten Forschern, die schon länger im Geschäft sind, offenbar wohlbekannt ist: Die Mehrzahl der Antworten lag zwischen drei und fünf Jahren.

Drei bis fünf Jahre lang könnte der Durchschnitts-Seniorforscher also noch Manuskripte schreiben — allein mit den Daten, die er längst schon hat. Da er diese Zeit aber beileibe nicht nur mit Paperschreiben verbringen kann, werden wohl jede Menge dieser interessanten kleinen (und hin und wieder vielleicht sogar großen) Geschichten niemals veröffentlicht. „Survival of the fittest results“ nennt die Autorin das treffend.

Woher aber kommt der entsprechende Selektionsdruck? Wohl daher, dass das Publikations-dominierte Belohnungssystem dem Forscher die folgende Zwickmühle beschert hat: Will er seinen Job gut machen, sollte er stets seine Resultate sorgfältig prüfen, hart nach alternativen Erklärungen fahnden und sie immer mit der aktuellen Literatur abgleichen. Das allerdings kostet Zeit. Wenn Forscher X aber zu viel Zeit mit diesen Dingen „vertrödelt“, riskiert er, als unproduktiv abgestempelt zu werden. Und dann kann es schnell schwer werden, weiterhin Fördergelder zu bekommen.

Also bunkert Forscher X das weniger dringende Material in der Schublade und schreibt lieber erstmal den nächsten Antrag — nicht zuletzt auch, um das Hauptprojekt der Gruppe weiter am Laufen zu halten. Wird dieser dann bewilligt, muss er natürlich umgehend die beantragten Projekte auch machen. Mit den resultierenden Daten muss er gleich wieder Paper schreiben, damit er frische Argumente für den nächsten Folgeantrag hat… — und so geht das Spiel in die nächste Runde

Und während diese Mühle unerbittlich weiter läuft, versinkt das, was er in der Schublade bunkert, tiefer und tiefer im Staub.

Wer weiß, wie viele kleine Schätze mit etwas weniger Antragsdruck von dort geborgen werden könnten..

Ralf Neumann

x

Die sogenannten Omiken haben die Biomedizin nachhaltig verändert. Seit die Rechnerkäfte wachsen und der Probendurchsatz mit immer größeren Mengen und immer schneller parallel machbar ist, heißt es: „Warum soll ich nur ein Gen/Protein analysieren, wenn ich alle auf einmal machen kann?“ Entsprechend gilt heutzutage derjenige, der nur an einem oder einer Handvoll Proteine/Gene forscht, oftmals als geradezu hoffnungslos rückständig.

Masse zählt also. Doch wie sieht es mit „Klasse“ aus? Welche Qualität haben etwa die Daten einer „Massenproduktion“ bezogen auf das einzelne Protein oder Gen?

Interessanterweise gingen in unseren beiden aktuellen Jubiläumsausgaben — Lab Times-Ausgabe 50 und „20 Jahre Laborjournal“ — gleich zwei Forscher auf diese Frage ein. Und mahnten Vorsicht beim Umgang mit Omik-Daten an.

Der ehemalige Gründungsdirektor des Dresdner Max-Planck-Instituts für Molekulare Zellbiologie und Genetik, Kai Simons, sagte im Lab Times-Interview:

Today, of course, you know… in every area we are confronted with thousands of proteins. That’s a big, big shift. We are facing complexity now but, we’re still using yesterday’s methods. Scientists are doing one gene after another and so forth and we know it is too slow. Then you try to put them into high-throughput… all these high-throughput papers, where most of the work is irreproducible. The problem is, nobody is responsible for the data. In the lab, when we work on one protein, we look for the optimal conditions; for example, when you want to do pull downs and identify interaction partners. However, we are trying to study thousands of proteins at once — using the same conditions for everything. It is obvious that there will be so much error. We have to come up with technological solutions to face the complexity.

Dazu passend referiert der Struktur-Molekularbiologe Patrick Cramer, Direktor am Göttinger Max-Planck-Institut für biophysikalische Chemie, in seinem Laborjournal-Essay folgende Anekdote:

Um die fehlenden zellulären Mechanismen zu finden, stiegen wir vor einigen Jahren in die funktionale Genomik ein. Da die Transkription vom genomischen Kontext abhängt, mussten wir die Genaktivität global erfassen, nicht nur exemplarisch an einzelnen Genen. Einige Strukturbiologen winkten damals ab. Die Daten aus der Genomik seien doch total verrauscht. Ich wolle das doch nicht ernsthaft versuchen. Als Kristallograph sei ich doch harte Daten gewohnt. Das verunsicherte mich.

Und er bilanziert:

Genomweite Daten und systemische Ansätze fließen also zunehmend in die Molekularbiologie ein. Das bereitet manchen Unbehagen, denn die Möglichkeiten zur Fehlinterpretation sind mannigfaltig. Gerade deshalb ist es wichtig, sich genomweiten Daten mit einem molekular-mechanistischen Verständnis zu nähern.

Klingt, als wären die Datenproduktionen der Omiken vor allem Vorarbeiten, die man bei speziellem Einzelinteresse unbedingt kritisch prüfen müsse.

Forscher erlebt man oftmals besonders sauer, wenn sie gerade ein Paper abgelehnt bekommen haben. Und manchmal poltert dann so einiges aus ihnen heraus. So auch im Fall von Forscher Brodel [Name geändert], den unser Chefredakteur vor einigen Tagen bei einer Sitzung traf:

„Daten, Daten und nochmals Daten“, grummelte er während einer Sitzungspause im Garten. „Immer nur Daten — das ist das Einzige, was heute zählt in der Wissenschaft. Ist es denn tatsächlich so schlimm, mal ein wenig über den Tellerrand zu schauen? Wo ist das Problem, wenn man mit den Daten mal ein wenig mehr herumjongliert, als immer nur verschämt gerade das hinein zu interpretieren, was sie sowieso für alle offensichtlich hergeben? Sollte man sie nicht vielmehr als Sprungbrett zu plausibler Spekulation nutzen, um damit am Ende neue Ideen, Hypothesen und Zusammenhänge zur Diskussion stellen? Ja, gehört gesunde Spekulation nicht untrennbar zur Fähigkeit, den eigenen Daten den richtigen Platz im «großen Ganzen» zuzuordnen, oder gar überhaupt aus einigen Mosaiksteinchen ein «Big Picture» zu visionieren? Steht sie nicht unweigerlich am Anfang der Entwicklung von Theoriegerüsten, die jeder noch so großen Datenflut erst ihren echten Wert geben?“

„Und genau auf diese Weise hatten Sie in ihrem Manuskript spekuliert?“, fragte der Chefredakteur.

Gestern hatte ein nicht ganz unbekannter Forscher in der Redaktion angerufen — nennen wir ihn „Schmidt“. Eigentlich hatte Schmidt nur ein relativ kleines Anliegen, aber wie solche Gespräche manchmal laufen — man geriet ein wenig ins Plaudern.

Im Rahmen dieser Plauderei erzählte uns Forscher Schmidt schließlich von einem Manuskript, das er fertig im Rechner habe — aber nicht abschicken könne, weil Kooperationspartner „Schneider“ plötzlich quergetrieben habe. Dieser sei mit der Darstellung, vor allem aber mit Schmidts Interpretation der Daten samt Schlussfolgerung nicht einverstanden. Schneiders Interpretation und Schlussfolgerung konnte sich hingegen wiederum Schmidt nicht anschließen. So standen sich Schmidt und Schneider unversöhnlich gegenüber und es kam zum Streit. Diesen Beitrag weiterlesen »