Der Peer Review ist das Herzstück der wissenschaftlichen Qualitätskontrolle. Egal, ob Publikationen, Evaluationen oder Förderanträge – stets zerbrechen sich Fachkollegen die Köpfe über den jeweiligen Inhalt, um abschließend ihre Daumen darüber zu heben oder zu senken.

Als Gutachter im Rahmen eines Peer Reviews tätig zu sein, gilt daher als Ehrensache. Die meisten Forscherinnen und Forscher begreifen es gar als inhärenten Teil ihrer Dienstpflicht – auch wenn Juristen dies formal verneinen. Wie auch immer, unter dem Strich opfern sie auf diese Weise viel von ihrer wertvollen Zeit, um der Wissenschaft das Begutachtungswesen letztlich als große, selbstlose Spende zu überreichen.

Welchem Betrag diese „Spende“ der Forscherinnen und Forscher an das System entspricht, haben unlängst die drei Psychologen Balazs Aczel, Barnabas Szaszi (beide Budapest) und Alex O. Holcombe (Sydney) abgeschätzt. Schon der Titel ihrer Publikation lässt die Dimension erahnen: „A billion-dollar donation: estimating the cost of researchers’ time spent on peer review“ (Res. integr. peer rev. 6: 14). Ihr Abstract startet denn auch:

Umfang und Wert der Peer-Review-Arbeit von Forschern sind für die Wissenschaft und die Veröffentlichung in Zeitschriften von entscheidender Bedeutung. Jedoch wird diese Arbeit zu wenig anerkannt. Überdies ist ihr Ausmaß unbekannt. Und zu selten werden alternative Wege zur Organisation der Peer-Review-Arbeit in Betracht gezogen.

Mit diesem Statement zog das Trio los, um „auf der Grundlage öffentlich zugänglicher Daten […] eine Schätzung des Zeitaufwands von Forschern und des gehaltsbezogenen Beitrags zum Peer-Review-System von Zeitschriften“ zu liefern. Also nur für die Begutachtung von zur Veröffentlichung eingereichten Manuskripten!

Ihre Ergebnisse fassten sie dann folgendermaßen zusammen:

Wir fanden, dass im Jahr 2020 die Gutachter weltweit über 100 Millionen Stunden mit Peer Reviews verbrachten – was mehr als 15.000 Jahren entspricht. Der geschätzte monetäre Wert der Zeit, die die Reviewer allein in den USA für die Begutachtung aufwenden, betrug 2020 über 1,5 Milliarden US-Dollar. Für in China tätige Gutachter liegt die analoge Schätzung bei über 600 Millionen US-Dollar, und für die Kollegen im Vereinigten Königreich bei fast 400 Millionen US-Dollar.

So gesehen entspricht also allein schon die Begutachtung von Manuskripten innerhalb eines Jahres einer Milliarden-Spende der Forschergemeinde! Wobei die Autoren sogar noch einschränken:

Es ist sehr wahrscheinlich, dass unsere Ergebnisse zu niedrig angesetzt sind, da sie nur einen Teil aller Zeitschriften weltweit widerspiegeln.

Und sie machen zum Abschluss nochmals klar:

Die Zahlen verdeutlichen den enormen Arbeits- und Zeitaufwand, den Forscher für das Publikationssystem aufbringen. Und sie machen deutlich, wie wichtig es ist, über alternative Möglichkeiten der Strukturierung und Bezahlung von Peer Reviews nachzudenken.

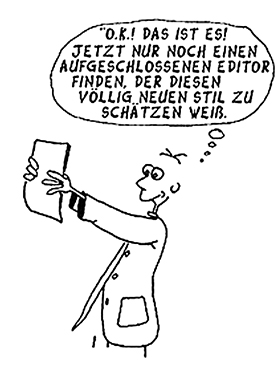

Oder man reformiert das Peer-Review-System gleich komplett von Grund auf. So wie es unser Wissenschaftsnarr beispielsweise gerade im Zusammenhang mit der breitflächigen Etablierung von Preprints vorschlägt – siehe seine Kolumne „Heilsbringer oder apokalyptische Reiter“. Und wie man überdies die ebenso aufwendigen Peer-Review-Verfahren bei der Verteilung von Fördergeldern eindampfen könnte, hatte er ja zuvor schon im Visier – siehe „Werden Sie Forschungsförderer!“ oder „Liebe DFG, verlost doch Eure Fördergelder!“.

Nur ein Beispiel, dass schon längst über Alternativen nachgedacht wird.

Ralf Neumann

(Illustr.: AdobeStock / jesussans)

__________________________

__________________________

Peer-Review soll bekanntlich die Qualität und Klarheit der Forschungsberichte verbessern. Doch Hand auf’s Herz – adressieren Sie bei der Überarbeitung eines zurückgeschickten Manuskripts tatsächlich in diesem Sinne alle substantiellen Einwände und Vorschläge der Reviewer, um es besser zu machen? Damit das Journal es im zweiten Anlauf womöglich akzeptiert?

Peer-Review soll bekanntlich die Qualität und Klarheit der Forschungsberichte verbessern. Doch Hand auf’s Herz – adressieren Sie bei der Überarbeitung eines zurückgeschickten Manuskripts tatsächlich in diesem Sinne alle substantiellen Einwände und Vorschläge der Reviewer, um es besser zu machen? Damit das Journal es im zweiten Anlauf womöglich akzeptiert?

Can tweets be used to detect problems early with scientific papers? A case study of three retracted COVID-19/SARS-CoV-2 papers – so lautet der Titel eines

Can tweets be used to detect problems early with scientific papers? A case study of three retracted COVID-19/SARS-CoV-2 papers – so lautet der Titel eines