Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel „What’s Wrong With Peer Review?“ Darin stellt die Autorin die Frage, ob angesichts vieler aufsehenerregender Retractions in der jüngsten Vergangenheit der Peer-Review-Prozess seine Funktion überhaupt noch erfüllt – nämlich zu entscheiden, welche Studien tatsächlich zur Veröffentlichung taugen.

Im Wall Street Journal erschien unlängst ein Artikel mit dem Titel „What’s Wrong With Peer Review?“ Darin stellt die Autorin die Frage, ob angesichts vieler aufsehenerregender Retractions in der jüngsten Vergangenheit der Peer-Review-Prozess seine Funktion überhaupt noch erfüllt – nämlich zu entscheiden, welche Studien tatsächlich zur Veröffentlichung taugen.

In dem Artikel erregte ein Zitat der Chief-Editorin von Nature, Magdalena Skipper, besondere Aufmerksamkeit. Hinsichtlich des Aufdeckens gezielter Fälschungen in Forschungsartikeln hält sie fest, dass dies keineswegs Job der Reviewer ist – und fügt hinzu:

Ich möchte meine Peer-Reviewer eigentlich nicht als eine Art Polizeikommando ansehen, das solches Fehlverhalten aufspürt.

Schon im Artikel werden Editoren-Kollegen mit anderer Meinung zitiert. Für noch mehr Diskussionen sorgte Skippers Aussage indes in den Sozialen Medien. So wunderte sich etwa die australische Psychologie-Professorin Simine Vazire auf X (ehemals Twitter):

Die Zitate der Nature-Chief-Editorin Magdalena Skipper zur Frage, ob Zeitschriften im Rahmen des Peer-Review auch auf Fehler und Datenqualität prüfen sollten, überraschen mich doch sehr.

Und mit dieser Überraschung war sie bei weitem nicht allein. Diesen Beitrag weiterlesen »

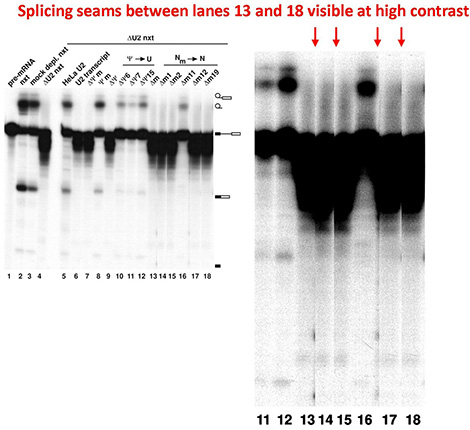

„Wissenschaftsbetrug ist selten. Stimmt das eigentlich?“ Diese Frage stellte unser „Wissenschaftsnarr“ Anfang des Jahres in seiner Laborjournal-Kolumne (

„Wissenschaftsbetrug ist selten. Stimmt das eigentlich?“ Diese Frage stellte unser „Wissenschaftsnarr“ Anfang des Jahres in seiner Laborjournal-Kolumne ( Letzte Woche ist unser

Letzte Woche ist unser

Über eine Reform des Peer Review-Systems lässt sich trefflich streiten. Ein immer wieder ins Feld geführtes Argument gegen den klassischen Peer Review ist jedoch nicht ganz fair: Dass die Zunahme getürkter Paper in der Forschungsliteratur doch zeige, wie unzulänglich die Begutachtung funktioniert. Beispielsweise in diesem

Über eine Reform des Peer Review-Systems lässt sich trefflich streiten. Ein immer wieder ins Feld geführtes Argument gegen den klassischen Peer Review ist jedoch nicht ganz fair: Dass die Zunahme getürkter Paper in der Forschungsliteratur doch zeige, wie unzulänglich die Begutachtung funktioniert. Beispielsweise in diesem

(

(